IA Act : Comment la France se prépare-t-elle ?

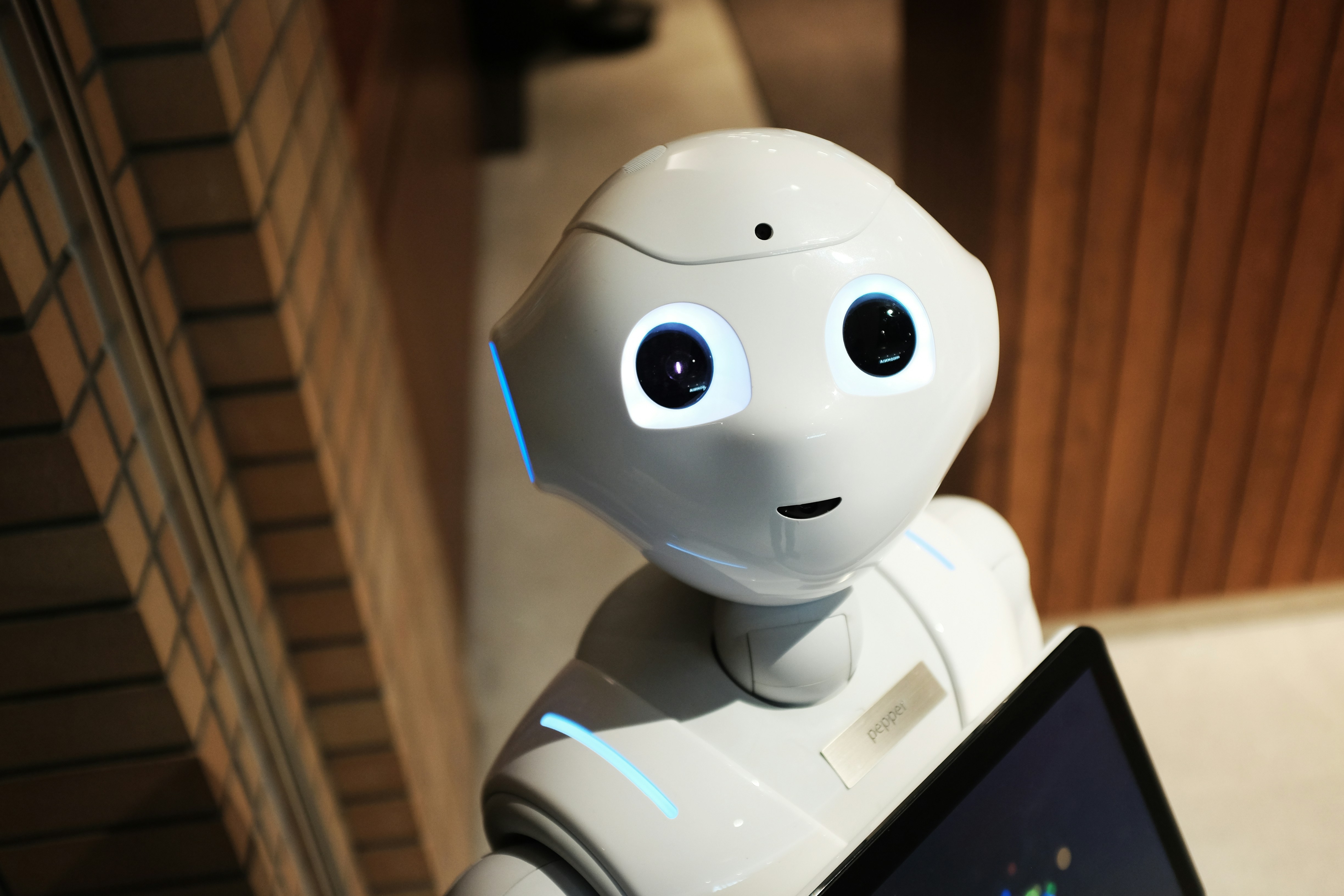

L’intelligence artificielle est en passe de devenir l’un des secteurs les plus encadrés juridiquement en Europe. Avec l’adoption de l’IA Act par le Parlement européen en 2024, l’Union européenne se dote du tout premier cadre juridique global visant à encadrer les systèmes d’IA selon leur niveau de risque. Mais comment la France, déjà active sur les enjeux numériques, anticipe-t-elle l’entrée en vigueur de cette réglementation inédite ? DécryptagL’IA Act, un règlement historique

Le règlement européen sur l’intelligence artificielle – ou IA Act – a pour objectif de garantir que l’IA soit “humaine, éthique et digne de confiance”. Il instaure une classification des systèmes d’IA en quatre catégories principales :

- Interdiction des IA à risque inacceptable (ex : reconnaissance faciale en temps réel dans l’espace public sauf exceptions, manipulation subliminale).

- Forte régulation des IA à “haut risque” (ex : IA dans le recrutement, services publics, santé, éducation).

- Obligations de transparence pour les IA génératives (ChatGPT, Midjourney) : mention obligatoire, respect du droit d’auteur.

- Liberté encadrée pour les IA à risque minimal (chatbots classiques, filtres automatiques).

Le texte entrera pleinement en application en 2026, avec certaines obligations dès 2025 pour les IA génératives.

La France : entre anticipation et adaptation

La France n’a pas attendu l’IA Act pour réfléchir à la régulation de l’intelligence artificielle. Dès 2018, le rapport Villani traçait les grandes lignes d’une stratégie éthique et compétitive. Avec le vote du règlement, le pays entre désormais dans la phase de mise en œuvre.

Selon les premières annonces officielles :

- La CNIL est confirmée comme régulateur de référence pour les questions de respect des droits fondamentaux dans l’IA.

- La Direction Générale des Entreprises (DGE) et France Stratégie travailleront sur l’accompagnement des entreprises à la conformité.

- Un pôle IA au sein de l’ARCOM devrait voir le jour pour surveiller l’utilisation de l’IA dans les médias et la publicité.

- Le Conseil National du Numérique est régulièrement consulté sur les enjeux éthiques liés aux algorithmes.

Quels secteurs français sont concernés ?

De nombreuses industries françaises sont directement impactées :

- Santé : systèmes de diagnostic assistés par IA, dispositifs médicaux intelligents.

- Sécurité : caméras intelligentes, logiciels prédictifs soumis à encadrement strict.

- Recrutement : les plateformes RH automatisées devront justifier leurs algorithmes.

- Services publics : l’État prévoit un audit systématique des IA utilisées (CAF, Pôle Emploi, impôts).

- Création numérique : les IA génératives (ex : IA audio, vidéo) devront mentionner leur statut, une révolution pour les médias et le secteur culturel.

Une tension entre innovation et régulation

La France veut se positionner comme une “puissance numérique régulée”, selon les mots du ministre délégué au numérique. L’ambition est double : garantir la protection des citoyens sans freiner la compétitivité des start-ups et des laboratoires de recherche.

Comme l’a récemment déclaré Marie-Laure Denis, présidente de la CNIL :

“Le défi, c’est un encadrement efficace qui protège les droits tout en laissant respirer l’innovation.”

Des voix, notamment au sein de la French Tech, s’inquiètent néanmoins d’un surcroît de bureaucratie qui pourrait ralentir les petites entreprises face aux géants américains et chinois.

Un calendrier déjà en route

- 2024 : adoption définitive du texte européen.

- 2025 : premières obligations sur la transparence des IA génératives.

- 2026 : entrée en vigueur complète de l’IA Act.

La France prévoit une transposition administrative rapide, avec des guides sectoriels pratiques dès 2025.

Face à ce changement majeur, la France joue un équilibre subtil : se doter d’un cadre robuste de protection des libertés, tout en restant attractive pour l’innovation. L’IA Act n’est pas seulement une contrainte, mais aussi une opportunité : celle de promouvoir un modèle européen éthique de l’intelligence artificielle.