IA et pédopornographie : enjeux juridiques et technologiques

L’utilisation de l’intelligence artificielle pour créer des images ou vidéos pédopornographiques, qu’elles soient réalistes ou non, est en forte augmentation. Les autorités judiciaires observent une multiplication inquiétante de ces contenus, certains mettant en scène des enfants réels, d’autres totalement fictifs mais très réalistes.

Des opérations internationales récentes ont conduit à plusieurs arrestations en France et dans d’autres pays. Même en l’absence de victimes réelles, ces contenus sont considérés comme une atteinte grave à la dignité humaine, car ils contribuent à normaliser la sexualisation des mineurs.

Ce phénomène rend également les enquêtes plus complexes : les forces de l’ordre doivent traiter un volume considérable de données, où il est difficile de distinguer le vrai du faux.

Internet Watch Foundation (IWF) – Rapport 2024 sur l'abus de l'IA pour créer des images pédopornographiques

L'IWF a publié un rapport en juillet 2024 soulignant l'augmentation significative de la production de contenu pédopornographique généré par l'IA. Le rapport indique que plus de 3 500 nouvelles images ont été téléchargées en un mois sur un forum du dark web, dont une proportion inquiétante représente des abus sexuels sur enfants de catégorie A. De plus, des vidéos de plus en plus réalistes, notamment des deepfakes, sont utilisées pour exploiter des enfants, parfois en insérant le visage d'un enfant réel dans une vidéo pornographique existante.

Un cadre juridique encore flou

En France

L’article 227-23 du Code pénal interdit la consultation, la détention et la diffusion d’images pédopornographiques, y compris les représentations fictives imitant l’apparence d’un mineur. Certains juristes réclament une incrimination explicite pour mieux encadrer ce phénomène.

En Europe

La directive européenne oblige les États membres à criminaliser la production et la diffusion de tout contenu pédopornographique, y compris les images générées par IA. L’application reste toutefois inégale selon les pays.

À l’international

Des pays comme le Royaume-Uni, l’Australie ou la Corée du Sud sanctionnent explicitement la création et la diffusion d’images sexuelles de mineurs générées par ordinateur, qu’elles soient réalistes ou fictives.

Problèmes de détection : un défi technologique

Identifier un contenu pédopornographique généré par IA est devenu l’un des défis les plus complexes pour les forces de l’ordre et les plateformes en ligne.

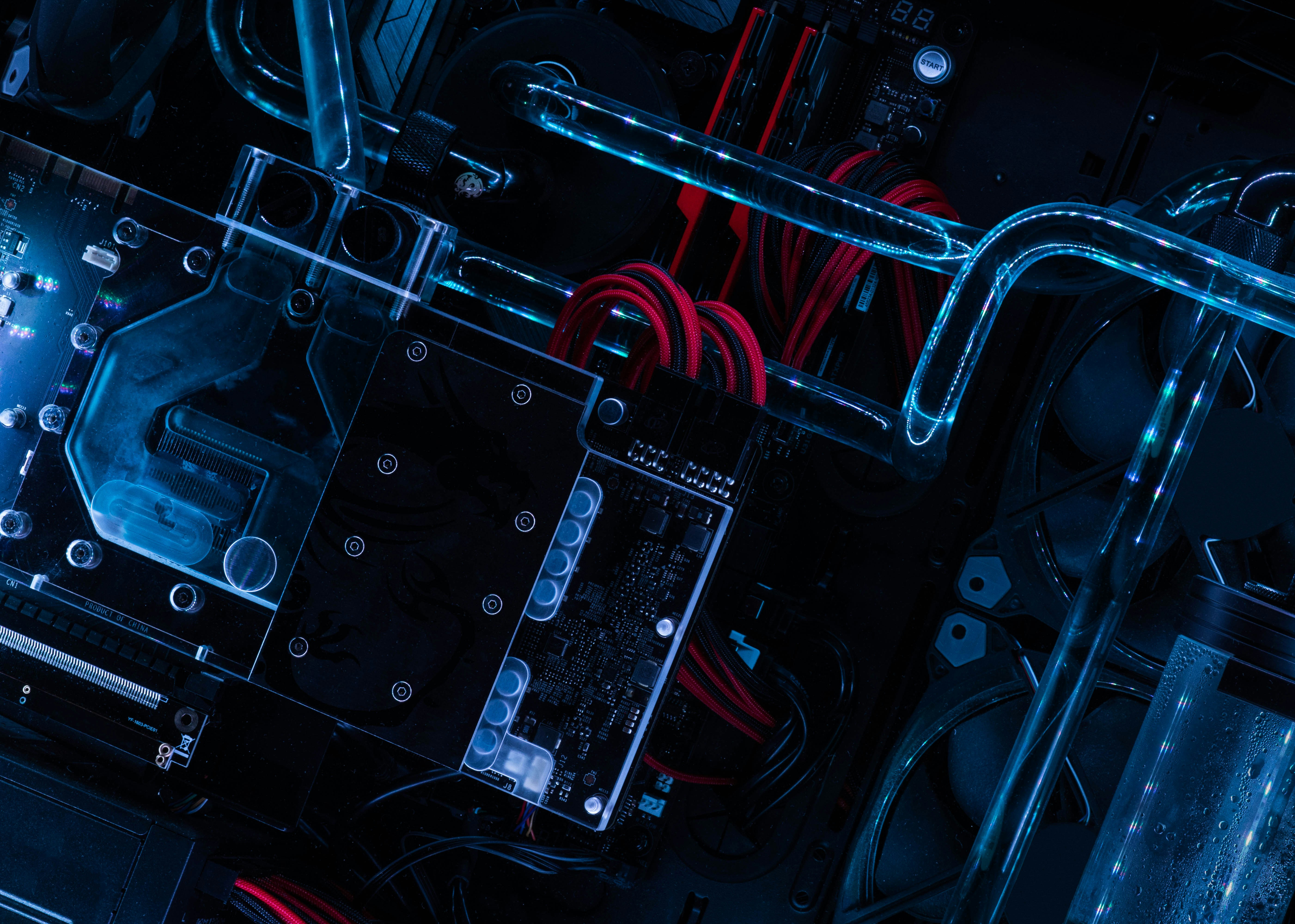

1. Limites des algorithmes actuels

Les systèmes de détection d’images pédopornographiques reposent historiquement sur des bases de données comme PhotoDNA ou HashScan, qui comparent chaque fichier à un “hash” numérique d’images déjà connues et signalées.

Problème : lorsqu’une image est générée par IA, elle ne correspond à aucune empreinte connue, ce qui rend ces systèmes inefficaces.

De plus, les modèles d’IA modernes peuvent produire des visuels photo-réalistes à partir de simples descriptions textuelles, rendant le repérage encore plus difficile.

2. Confusion entre le vrai et le faux

Les enquêteurs doivent désormais répondre à une question cruciale :

“Est-ce qu’une personne réelle a été impliquée dans la création de cette image ?”

Même un expert humain peut hésiter, car les IA reproduisent des détails anatomiques, des textures de peau, et des imperfections réalistes, ce qui brouille les repères visuels.

Cette incertitude complique aussi la procédure judiciaire : une image entièrement fictive mais réaliste peut nécessiter une expertise longue avant qu’un juge statue sur sa qualification pénale.

3. Multiplication du volume à analyser

Selon Europol, la quantité de contenus suspects interceptés chaque année dépasse déjà des dizaines de millions de fichiers. Avec l’IA, cette masse risque d’exploser, car une seule personne peut générer des centaines d’images par heure à très faible coût.

Les équipes d’analystes doivent donc traiter des volumes bien supérieurs à leurs capacités humaines, ce qui entraîne un retard dans les enquêtes et le risque de laisser passer des éléments critiques.

4. Détournement des IA génératives

Certains utilisateurs exploitent des failles dans les protections mises en place par les services d’IA (comme les filtres anti-contenus sexuels) pour créer ces visuels interdits.

Méthodes constatées :

- Modification des requêtes pour tromper les filtres (ex. utiliser des codes ou synonymes)

- Entraînement local d’IA non filtrées sur des bases d’images illégales

- Altération progressive d’images réelles pour en créer de nouvelles indétectables

5. Pistes de solutions technologiques

Les chercheurs explorent plusieurs approches :

- Filigranes numériques obligatoires (watermarking) pour identifier toute image générée artificiellement dès sa création.

- Systèmes d’analyse morphologique avancée capables de détecter des anomalies typiques des visuels IA (textures trop parfaites, incohérences dans les détails anatomiques, artefacts visuels).

- Partage international des signaux IA : une base commune où chaque contenu suspect détecté par une plateforme est enregistré et partagé avec les autres acteurs.

Solutions émergentes

Pour améliorer la détection et la prévention, plusieurs pistes sont étudiées :

- Renforcement des filtres des plateformes pour supprimer rapidement les contenus illicites.

- Technologies avancées de reconnaissance capables d’identifier les contenus générés par IA.

- Collaboration internationale pour partager les fichiers suspects et uniformiser les protocoles.

- Campagnes de sensibilisation pour réduire la demande et éduquer le public sur les dangers de ces images.

Témoignages et réactions d’experts

Les autorités policières européennes rappellent que même un contenu fictif peut avoir un effet pervers : il alimente la demande et entretient un marché illégal. Des associations de protection de l’enfance soulignent qu’il faut autant prévenir que sanctionner.

Des spécialistes du droit pénal numérique appellent à harmoniser rapidement les législations pour éviter que ce type de production prospère dans les zones grises.

Perspectives d’avenir

Pour lutter efficacement contre ce phénomène, plusieurs pistes sont envisagées :

- Harmonisation législative européenne pour combler les zones floues.

- Renforcement des obligations des plateformes pour détecter et supprimer les contenus illicites.

- Investissement dans la recherche technologique pour améliorer les systèmes de détection automatisée.

- Encadrement strict des outils d’IA avec filtres intégrés dès la création.

Face à la multiplication des contenus pédopornographiques, les parents ont un rôle essentiel pour protéger leurs enfants :

- Ne pas publier de photos d’enfants sur les réseaux sociaux, surtout dans des situations intimes ou reconnaissables.

- Limiter les informations personnelles : nom complet, école, adresse ou habitudes quotidiennes peuvent être exploitées par des prédateurs.

- Surveiller l’usage des appareils et des applications par les enfants, en expliquant les risques liés au partage de contenu personnel.

- Sensibiliser les enfants aux dangers d’Internet et à l’importance de signaler tout contact suspect.

Ces gestes simples peuvent réduire le risque que l’image ou l’identité de l’enfant soit utilisée pour générer des contenus illégaux. Pour aller plus loin sur les droits et limites numériques d'un parent sur son enfant, notre article "Fouiller le téléphone ou installer un contrôle parental à son enfant, est-ce légal ?".

FAQ – IA et pédopornographie

1. L’IA génératrice de contenus pédopornographiques est-elle illégale en France ?

Oui. Même fictif, un contenu représentant un mineur peut être poursuivi.

2. Pourquoi ce sujet est-il préoccupant ?

Ces images contribuent à banaliser l’exploitation sexuelle des enfants et peuvent encourager le passage à l’acte.

3. Comment détecte-t-on ces contenus ?

Des outils d’IA détectent les images suspectes, mais une analyse humaine reste essentielle.

4. Quels pays sanctionnent déjà l’IA ?

Le Royaume-Uni, l’Australie, la Corée du Sud et certains autres États ont intégré ce cas dans leur législation.

5. Quelles sont les prochaines étapes possibles ?

Harmonisation internationale, technologies de détection renforcées et cadre légal clair sont prioritaires.