Qui contrôle les IA ? Les limites floues de la régulation mondiale

Une régulation mondiale en puzzle

À l’heure où les IA génératives rédigent, créent, décident — parfois sans supervision humaine — la question de leur encadrement devient urgente. Pourtant, sur la scène mondiale, la régulation de l’intelligence artificielle ressemble à un patchwork aux logiques divergentes.

🇪🇺 Union européenne : pionnière mais prudente

Avec l’AI Act, adopté en mars 2024, l’Europe a pris une longueur d’avance. Ce règlement instaure un système de classification des IA par niveaux de risque. Certaines pratiques, comme la surveillance biométrique de masse ou les systèmes de scoring social, y sont interdites. Les IA à “haut risque” (dans les domaines de la santé, du travail, de la sécurité…) sont soumises à des obligations strictes de transparence, d’explicabilité et de supervision humaine.

Bruxelles affirme ainsi une vision éthique et humaniste de l’IA, en phase avec le RGPD. Mais les critiques pointent déjà le risque d’étouffer l’innovation face à des concurrents plus agressifs.

🇨🇳 Chine : encadrement autoritaire et centralisé

À l’inverse, la Chine déploie un modèle vertical, où l’IA est considérée comme un levier de puissance nationale. Le gouvernement chinois impose aux entreprises d’IA générative — comme Baidu ou Tencent — de soumettre leurs algorithmes à l’approbation des autorités.

En juillet 2023, la Cyberspace Administration of China (CAC) a publié une série de règles pour interdire la diffusion de contenus « subversifs » ou « contraires à l’ordre public ». Le contrôle ne s’arrête pas au contenu : l’architecture même des systèmes doit être alignée sur les objectifs de l’État.

🇺🇸 États-Unis : laissez-faire technologique

Aux États-Unis, l’approche est plus libérale. Il n’existe aucune loi fédérale spécifique à l’IA, mais une mosaïque d’initiatives au niveau des États (comme la Californie ou New York). En octobre 2023, l’administration Biden a publié un executive order encourageant les bonnes pratiques (sécurité, transparence, lutte contre les biais), mais sans mécanisme contraignant.

Le Congrès, divisé sur la question, peine à imposer une régulation cohérente. Résultat : les Big Tech (OpenAI, Google, Microsoft...) dictent de facto les règles du jeu à travers des chartes éthiques maison, peu ou pas auditées par des tiers.

🗺️ Un monde éclaté

Selon une étude de l'OCDE, plus de 1 600 initiatives réglementaires sur l’IA ont été identifiées dans 60 pays en 2023. Le paysage est fragmenté, et cette hétérogénéité nourrit les inégalités d’accès, les dérives de surveillance et le « forum shopping » réglementaire : les entreprises installent leurs serveurs ou testent leurs IA là où les règles sont les plus souples.

Pourquoi les limites de la régulation de l’IA sont-elles floues ?

La régulation de l’intelligence artificielle est un défi juridique, technologique et politique. Et les "limites floues" dont on parle souvent désignent autant les zones grises du droit que les frontières mouvantes de la technologie. Voici pourquoi :

1. L’IA évolue plus vite que les lois

Le cycle de vie d’une loi est long : consultation, rédaction, validation, mise en application… alors qu’un modèle d’IA peut passer d’un prototype à une solution globale en quelques mois.

➡ Résultat : les textes réglementaires sont souvent dépassés avant même leur entrée en vigueur. Les législateurs courent derrière des systèmes qu’ils ne maîtrisent pas toujours.

📣 Alexei Grinbaum (CEA) : « Nous ne savons pas quelles capacités auront ces intelligences dans cinq ans. Alors comment légiférer aujourd’hui sur ce que nous ne comprenons pas encore ? »

CTRLZed est d'ailleurs initialement engagé dans l'amélioration de l'effectivité et de la production de la législation du numérique.

2. Les définitions juridiques restent floues

Qu’est-ce qu’une "IA à haut risque" ? Où s’arrête un "système autonome" ? Comment prouver qu’un algorithme a causé un dommage ?

Les textes européens ou américains peinent à définir précisément les termes techniques et juridiques, ce qui laisse la porte ouverte à des interprétations différentes, voire à des contournements. Ce qui en droit, ne peut être envisageable.

3. La responsabilité est diluée

En cas de dérive ou d’erreur d’une IA, qui est responsable ? Le développeur ? L’entreprise utilisatrice ? Le fournisseur du modèle préentraîné ?

L’absence de responsabilité claire rend l’application du droit complexe, notamment en cas de discrimination algorithmique ou de décision automatisée injuste.

⚖️ Winston Maxwell (Télécom Paris) : « Le droit repose sur des chaînes de causalité. Mais avec l’IA, ces chaînes sont parfois opaques, voire cassées. »

➡ Ce point là pose de multiples questions, sans réponses, mais dont de nombreux professionnels se consacrent.

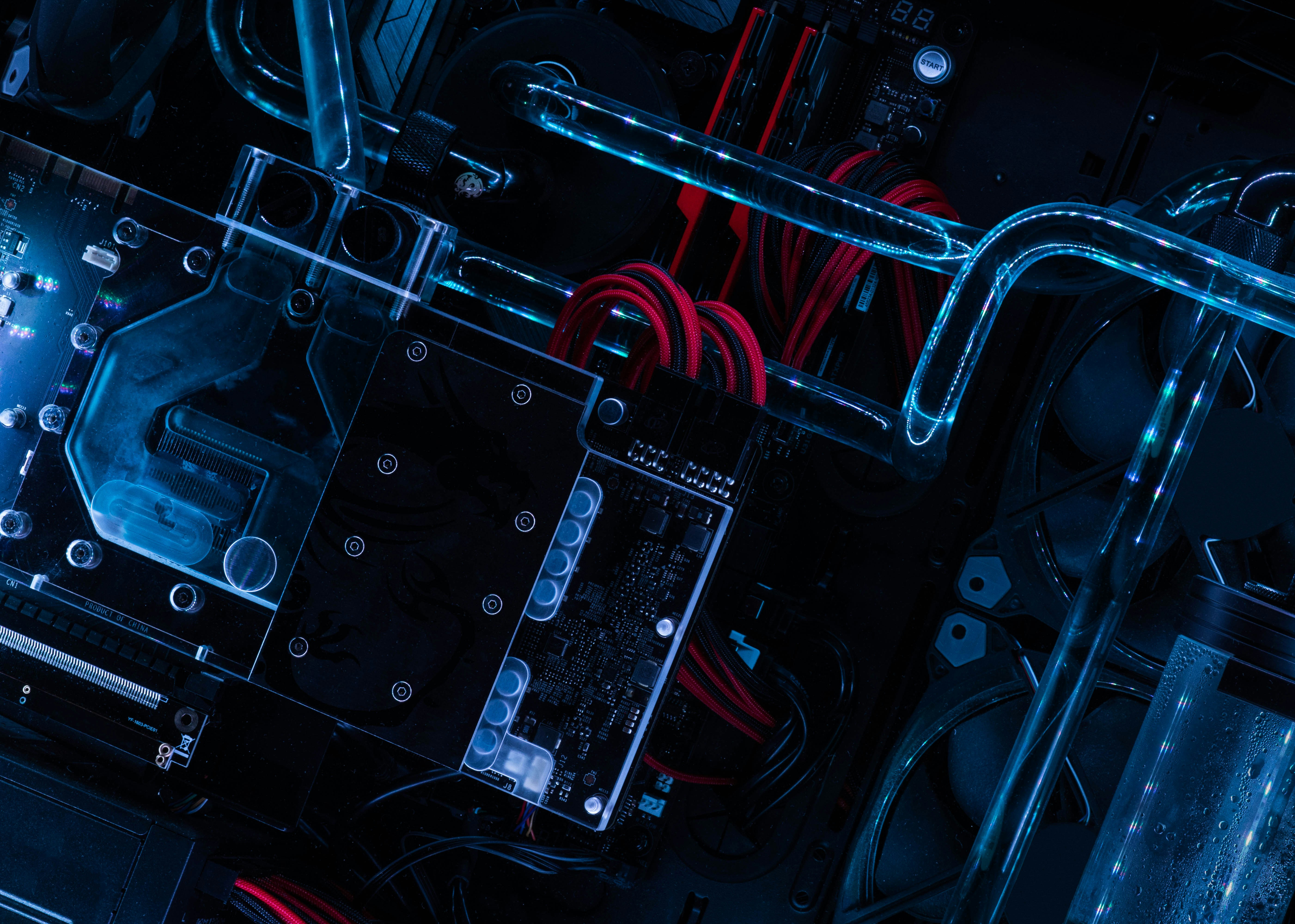

4. Les IA sont de plus en plus opaques

Les modèles d’IA modernes, notamment les modèles de langage ou les réseaux neuronaux profonds, fonctionnent comme des "boîtes noires".

Même leurs concepteurs ne savent pas toujours expliquer pourquoi une IA a pris telle ou telle décision. Cela rend le contrôle réglementaire presque impossible sans outils techniques avancés — et là encore, tout le monde n’y a pas accès.

5. Régulations divergentes, impacts globaux

Une IA développée à San Francisco peut être déployée à Nairobi, modifiée à Berlin et hébergée à Singapour.

Dans ce contexte transnational, les régulations locales n’ont qu’un pouvoir partiel. Sans coordination internationale, les règles d’un pays peuvent être contournées depuis un autre.