Les biais algorithmiques en justice

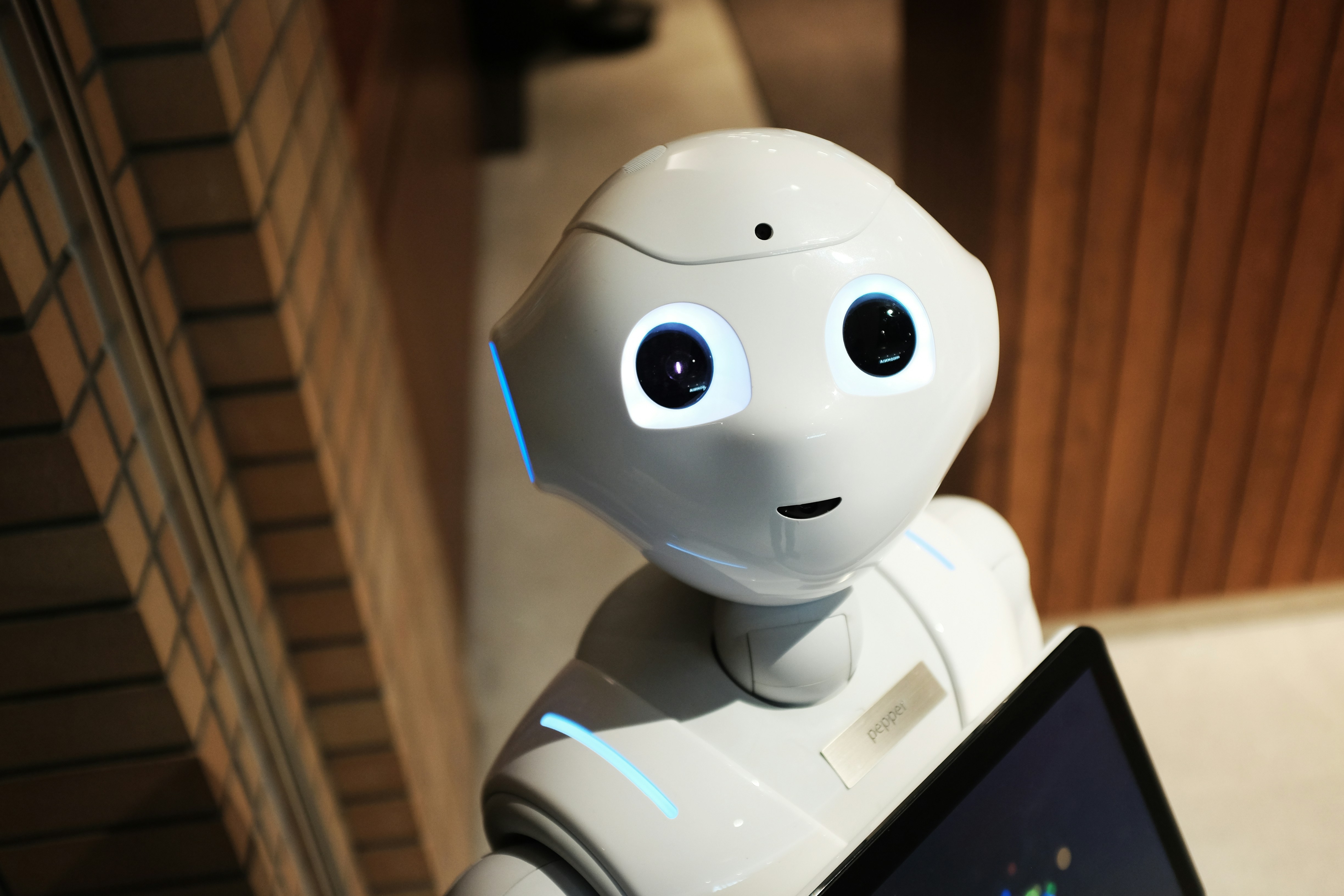

L'essor de l'intelligence artificielle et des algorithmes dans les institutions publiques, y compris la justice, soulève une question cruciale : peut-on déléguer des décisions juridiques à des systèmes potentiellement biaisées ?

De la prévision de récidive à l'aide à la décision judiciaire, les algorithmes s'invitent dans les tribunaux.

Mais ils ne sont pas neutres. Pire : ils reproduisent, et parfois amplifient, les discriminations humaines.

Comprendre les biais algorithmiques

Qu'est-ce qu'un biais algorithmique ?

Un biais algorithmique est une distorsion systématique dans le traitement des données ou la prise de décision par un algorithme, généralement causée par des données biaisées (ex: historiques de décisions humaines discriminatoires), des modèles mal calibrés, ou des objectifs mal définis.

Ex : Si un algorithme est entrainé sur des décisions de justice passées où les personnes racisées ont reçu des peines plus lourdes, il apprendra à reproduire cette logique.

Les biais, un héritage de données

Les biais ne viennent pas de l'IA elle-même, mais des données d'entraînement et des objectifs qu'on lui fixe.

On parle alors de biais historiques, biais de sélection, ou encore biais de confirmation.

Des algorithmes déjà présents dans les tribunaux

Le cas emblématique : COMPAS (États-Unis)

COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) est un logiciel d'évaluation du risque de récidive utilisé par plusieurs juridictions américaines.

Enquête de ProPublica (2016) : COMPAS avait deux fois plus de faux positifs chez les Afro-Américains que chez les blancs.

Les Noirs étaient jugés à tort à haut risque de récidive bien plus souvent.

Justice prédictive en France : l'exemple de l'entreprise Predictice

Predictice est une entreprise française qui propose des outils de jurisprudence augmentée, permettant d'analyser les chances de succès d'un litige. Même si ce type d'outil est présenté comme un assistant à la décision, il pourrait à terme orienter des juges vers des décisions statistiquement probables...

Au détriment de la singularité de cas.

Les risque éthiques et juridiques

Des risques pour les droits fondamentaux comme des atteintes à l'égalité devant la justice, la déshumanisation du jugement (prédiction automatiques sans prise en compte des particularités individuelles), ou une transparence limitée : les algorithmes sont souvent des boites noires.

La CNIL et le Conseil d'État en France ont alerté dès 2018 sur les dangers de l'automatisation des décisions juridictionnelles.

"L'intelligence artificielle ne peut être un juge." _ Conseil d'État, Étude annuelle 2018 sur l'IA et l'action publique.

Que dit la loi ?

En France, le Code de justice administrative interdit la décision juridictionnelle entièrement automatisée, la loi du 20 Juin 2018 interdit l'analyse de données des décisions de justice pour identifier les juges nommément (suite à l'essor de Legaltech comme Lexbase ou Doctrine).

À l'échelle européenne, le règlement IA de l'Union européenne (AI Act) classe les outils d'aide à la décision judiciaire comme '"à haut risque", imposant des exigences strictes de transparence, supervision humaine et non-discrimination.

L'introduction des algorithmes dans le champ judiciaire pose une tension majeure entre efficacité technologique et exigence de justice équitable. Plutôt qu'une déléguation, c'est une cohabitation critique qui s'impose : l'humain doit garder la main, tout en s'appuyant prudemment sur l'outil algorithmique.