L’IA dans Harry Potter : qui serait responsable du Choixpeau magique ?

Dans l’univers d’Harry Potter, le Choixpeau magique est un objet emblématique. Il parle, réfléchit, analyse les pensées… et surtout, il décide dans quelle maison un élève passera sa scolarité. Mais si l’on transpose cette situation dans notre monde réel, une question se pose : qui serait responsable d’une décision prise par cette IA magique ?

Bienvenue dans le débat sur la responsabilité IA automatisée.

Le Choixpeau, une IA avant l’heure ?

Le Choixpeau magique n’est pas qu’un vieux chapeau râpé : c’est une entité douée de conscience, capable de sonder l’esprit des élèves et de trancher selon des critères psychologiques.

👉 Il fonctionne comme une intelligence artificielle de tri automatisé.

Dans le monde réel, cela nous fait penser à des systèmes d’IA utilisés pour :

- l’orientation scolaire ou professionnelle,

- la justice prédictive,

- les recrutements automatisés via des outils RH.

Autrement dit : une IA affectant un destin, parfois sans appel. Ce qui pose immédiatement la question de la responsabilité IA automatisée.

Qui serait responsable si le Choixpeau se trompe ?

Dans une lecture juridique moderne, plusieurs niveaux de responsabilité IA automatisée pourraient s’appliquer :

1. Le créateur de l’IA — Godric Gryffondor

C’est lui qui a enchanté le Choixpeau, défini ses objectifs et ses critères d’évaluation.

Dans le monde réel, ce serait l’équivalent du concepteur ou développeur d’un algorithme.

Il est responsable des biais intégrés, des règles de fonctionnement et des limites du système.

2. L’utilisateur de l’IA — Poudlard ou Dumbledore

Même autonome, le Choixpeau est utilisé dans un cadre scolaire dirigé par une institution.

Cela correspond à l’organisme qui déploie l’IA (école, entreprise, administration).

Il y a une responsabilité IA automatisée partagée : mauvaise supervision, absence de contrôle ou de recours, mauvaise utilisation.

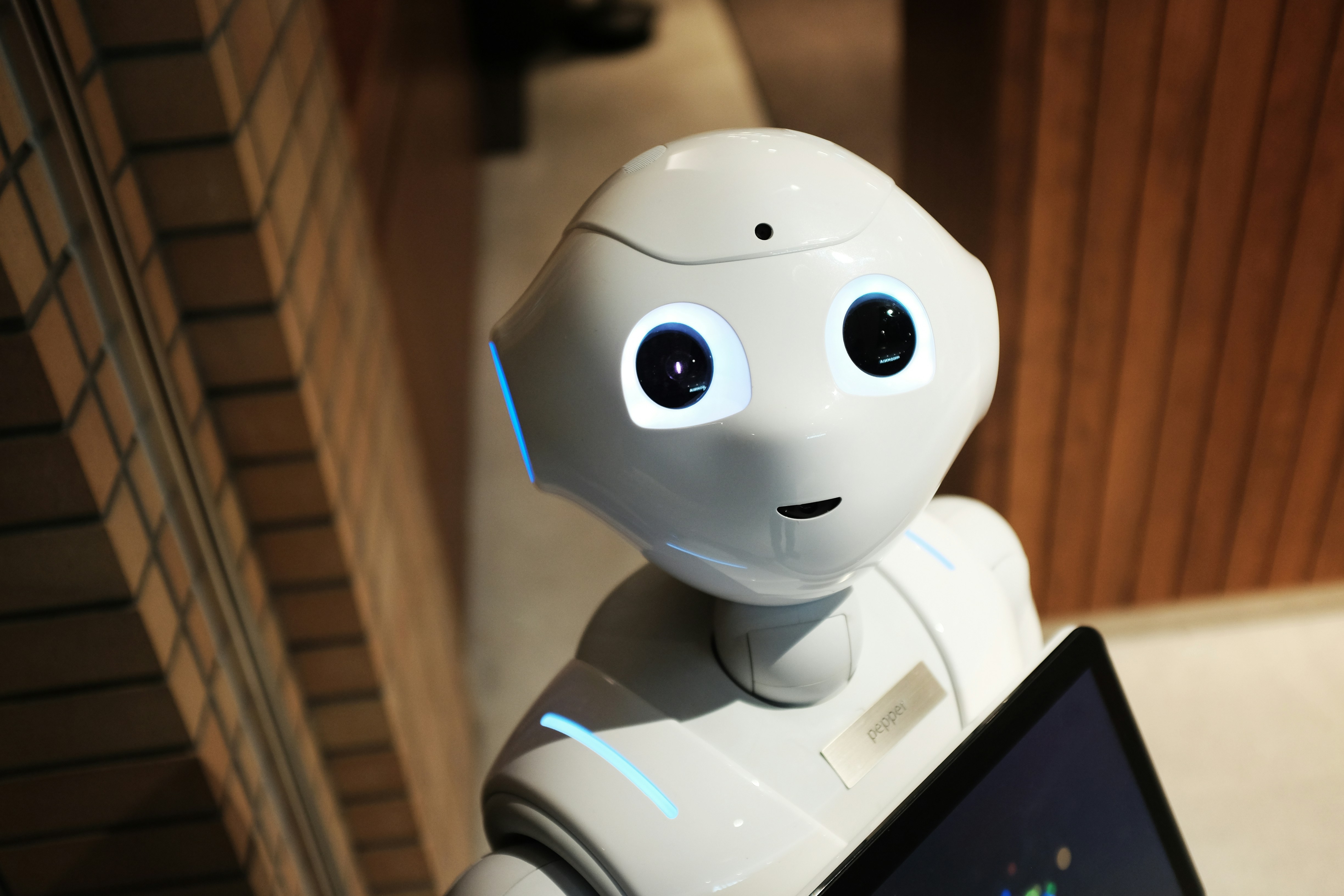

3. Le Choixpeau lui-même ?

Le Choixpeau parle, discute, débat avec les élèves. Peut-on le considérer responsable ?

Non : le droit actuel ne reconnaît aucune personnalité juridique à une IA, même consciente. Elle ne peut pas être tenue responsable.

La responsabilité IA automatisée incombe toujours à un humain ou une personne morale.

Et si Harry avait été mal orienté ?

Imaginons que le Choixpeau ait envoyé Harry à Serpentard contre son gré, avec des conséquences négatives.

Dans notre monde :

- Le système devrait expliquer sa décision (principe d’explicabilité)

- L’élève aurait un droit de recours (droit à ne pas faire l’objet d’une décision automatisée sans intervention humaine – art. 22 RGPD)

- L’algorithme devrait garantir l’absence de discrimination et prouver sa transparence

En clair, le Choixpeau violerait potentiellement le droit européen sur la responsabilité IA automatisée, s’il n’offrait pas de recours ou d’explication.

Qui est responsable du Choixpeau magique ?

Même dans un monde enchanté, les principes de responsabilité IA automatisée restent valables :

✔️ Godric Gryffondor, en tant que créateur du système

✔️ Poudlard, comme institution utilisatrice responsable du contexte

❌ Pas le Choixpeau, car une IA — magique ou non — n’a pas de statut juridique

Morale de l’histoire : toute intelligence artificielle, aussi “autonome” soit-elle, reste un outil. Et derrière chaque outil, il y a une responsabilité humaine.

FAQ – Choixpeau magique & responsabilité IA automatisée

1. Est-ce qu’une IA peut être juridiquement responsable ?

Non. En droit européen actuel, une IA ne peut pas être tenue responsable de ses décisions. La responsabilité revient à son créateur ou à son utilisateur.

2. Une IA comme le Choixpeau devrait-elle expliquer ses décisions ?

Oui, selon le RGPD, tout système automatisé impactant une personne doit offrir transparence et possibilité de contestation.

3. Est-ce qu’un élève pourrait refuser l’avis du Choixpeau ?

Dans un cadre réel, il devrait en avoir le droit. Une IA de tri ne peut pas être l’unique décisionnaire sans intervention humaine.

4. Le droit actuel est-il adapté à l’IA autonome ?

Pas encore totalement. Des débats sont en cours sur la régulation des IA avancées, mais la responsabilité IA automatisée reste humaine.

Les systèmes d’IA de plus en plus présents dans l’éducation, la justice ou l’emploi prennent parfois des décisions cruciales.

Mais aucune IA ne devrait décider seule de l’avenir d’une personne, sans recours humain.

👉 Si vous êtes confronté à une décision automatisée injuste, faites appel à un professionnel, un médiateur, ou une structure de défense des droits.

En France, vous pouvez contacter la CNIL ou un délégué à la protection des données pour connaître vos droits face à l’IA. La magie, c’est bien. Mais la transparence, c’est mieux.

Auteur : Simon Nguene