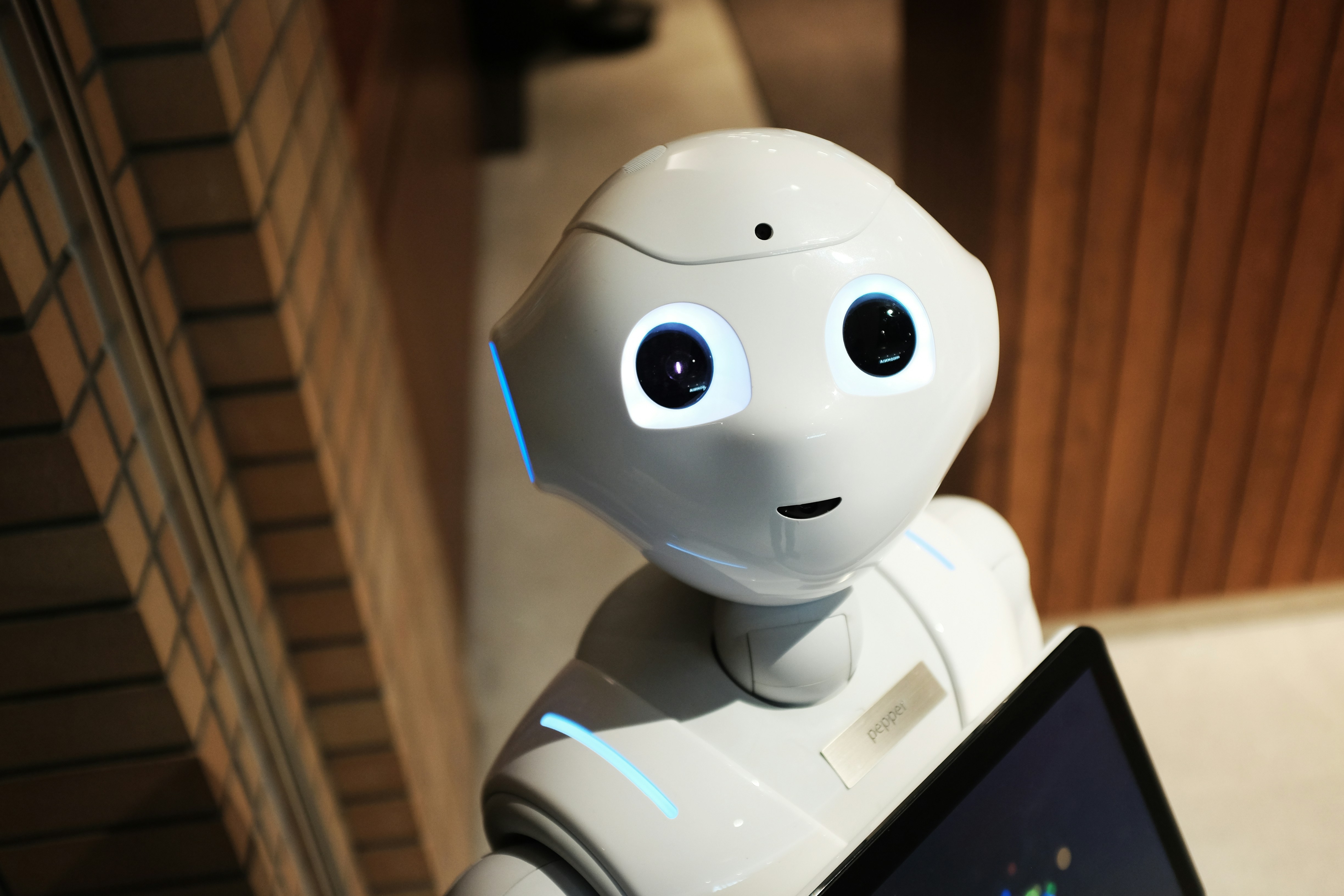

L'intelligence artificielle au service de la justice : un rapport structurant de la Cour de cassation

Le 28 avril 2025, la Cour de cassation a publié un rapport très attendu intitulé "L'intelligence artificielle au service de la justice". Ce document, élaboré par un groupe pluridisciplinaire de magistrats, juristes, ingénieurs et spécialistes des données, trace les grandes lignes d'une future intégration maîtrisée de l'intelligence artificielle (IA) dans le fonctionnement judiciaire français, en particulier au sein de la plus haute juridiction de l'ordre judiciaire.

Une ambition : améliorer l'efficacité sans céder la souveraineté judiciaire

L'objectif affiché par la Cour est clair : renforcer l'efficacité des traitements judiciaires, notamment par l'automatisation de certaines tâches répétitives ou documentaires, tout en affirmant une ligne rouge : la décision judiciaire restera strictement humaine.

Cinq grandes catégories d'usages ont été identifiées :

- Enrichissement automatique des documents juridiques (annotation, indexation, mise en lien de jurisprudence).

- Aide à la rédaction et à l'analyse des mémoires.

- Organisation et priorisation intelligente des dossiers.

- Assistance au greffe dans la gestion et la répartition des flux.

- Veille juridique automatisée pour la mise à jour constante des références jurisprudentielles.

Des garde-fous clairs : éthique, transparence, non-discrimination

Le rapport insiste avec force sur la nécessité d'encadrer ces nouveaux outils dans un cadre de confiance. Sont ainsi érigés en principes directeurs :

- Ces principes directeurs reposent sur plusieurs fondements essentiels. D'abord, la maîtrise humaine doit être garantie tout au long du processus, sans jamais déléguer une part de la responsabilité à la machine. Les algorithmes mis en œuvre doivent être transparents, compréhensibles et auditables. Toute décision appuyée par une IA devra pouvoir être tracée dans ses étapes et justifiée par une logique explicite. Le respect du principe de non-discrimination algorithmique est également fondamental pour éviter les biais systémiques. Enfin, une gouvernance spécifique doit être mise en place, intégrant un comité d'éthique et un dispositif de suivi scientifique pour encadrer et ajuster les usages de ces technologies.

L'exclusion explicite des algorithmes prescriptifs

Le rapport marque une position nette : l’intelligence artificielle ne doit en aucun cas participer à la prise de décision judiciaire. Il est formellement exclu qu’un algorithme recommande, préconise ou suggère une solution juridique ou judiciaire, même à titre indicatif. Cette position vise à préserver la souveraineté de l’intelligence humaine dans l’interprétation du droit, la pesée des arguments et l’appréciation des situations de fait, éléments essentiels de l’acte de juger.

Concrètement, cela signifie qu’un logiciel, même très performant, ne pourra jamais remplacer l’analyse contextuelle d’un magistrat dans un litige familial, ni déterminer la peine dans un procès pénal, même à partir de cas similaires enregistrés dans une base de données. L’IA pourra en revanche être utilisée pour des fonctions strictement logistiques : par exemple, trier automatiquement les dossiers par date ou par nature juridique, suggérer des décisions proches dans la jurisprudence, ou encore repérer des lacunes documentaires dans un mémoire.

Cette distinction rigoureuse entre l’assistance technique et la décision souveraine vise à éviter toute dérive vers une « justice automatisée », où les choix humains seraient délégués à des machines opaques. Le rapport appelle donc à une vigilance constante et à une régulation forte dans les usages futurs de ces technologies au sein de la justice.

Une formation des acteurs : condition sine qua non

Le succès du projet repose sur l’accompagnement des magistrats, greffiers et personnels judiciaires. Des formations spécifiques sont donc prévues pour permettre une appropriation éclairée des outils, ainsi qu’une posture critique vis-à-vis de leurs limites. À titre d'exemple, un module de formation destiné aux juges pourrait inclure une simulation d'analyse automatisée de jurisprudence, au cours de laquelle le magistrat apprend à repérer les biais éventuels dans les suggestions d’IA, à vérifier l'exactitude des liens jurisprudentiels proposés, ou encore à corriger une classification automatique erronée. Ce type d'exercice pédagogique permettrait non seulement de mieux comprendre le fonctionnement des outils, mais aussi de renforcer le rôle de contrôle humain indispensable à leur bon usage.

Une avancée pragmatique dans l’ère numérique judiciaire

Ce rapport constitue une première brique vers une transformation numérique plus large de l’appareil judiciaire. S’inscrivant dans les valeurs fondamentales du droit, il cherche un équilibre entre modernité technologique et respect des garanties procédurales. Une telle initiative pourrait inspirer d'autres juridictions européennes ou internationales confrontées aux mêmes défis.

Sources :