Ton psy est un robot (et il stocke tout) : que fait l’IA thérapeutique de tes confessions ?

Aujourd’hui, de plus en plus de personnes se tournent vers l’intelligence artificielle pour parler de leurs problèmes et se sentir écoutées. Parfois par manque de temps, souvent par manque de moyens — car consulter un psy, ce n’est pas à la portée de tout le monde.

Alors on cherche du réconfort ailleurs : applis de soutien émotionnel, chatbots bienveillants, voire même… ChatGPT. Ces intelligences artificielles semblent nous comprendre. Elles écoutent, répondent, rassurent. Et l’illusion est parfaite : on se sent compris.

Mais à force de confier ses pensées les plus intimes à une machine, une question dérangeante émerge :

👉 Où vont toutes ces données personnelles IA thérapie ?

👉 Et que dit le droit sur cette nouvelle forme de thérapie… sans thérapeute ?

Tu te livres, l’IA mémorise

Tu parles de ton anxiété, de tes insomnies, de tes pensées sombres. L’IA te répond avec empathie apparente.

Mais attention :

- Tes mots deviennent des données personnelles IA thérapie ;

- Les échanges sont souvent enregistrés et analysés ;

- Et tu n’es pas dans un cadre de soin réglementé.

Même sur ChatGPT, si l’historique des discussions est activé, ce que tu dis peut servir à entraîner le modèle. C’est écrit noir sur blanc.

ChatGPT, Replika, Woebot… même logique

- ChatGPT : n’est pas conçu pour faire de la thérapie. Mais il est souvent utilisé comme confident numérique. Par défaut, tes données personnelles IA thérapie peuvent être analysées.

- Woebot : chatbot fondé sur les TCC (thérapies comportementales et cognitives). Tes échanges servent à améliorer ses performances.

- Replika : une IA qui peut devenir « amie » ou même « partenaire romantique ». Mais tout est stocké sur des serveurs américains, hors RGPD.

- Wysa : IA de soutien émotionnel, avec une version premium plus respectueuse de la confidentialité.

⚠️ Aucune de ces IA n’est soumise au secret médical.

Et le droit, dans tout ça ?

En Europe, le RGPD protège les données sensibles — comme les données personnelles IA thérapie — mais à condition que l’outil respecte les lois locales. Ce qui n’est pas toujours le cas.

- Ces IA ne sont pas considérées comme des professionnels de santé.

- Leurs CGU permettent souvent l’usage de tes messages à des fins techniques ou commerciales.

- Et si les serveurs sont basés hors UE, comme aux États-Unis, ils échappent aux protections du droit européen.

Aux USA, tant que l’IA n’est pas reconnue comme un dispositif médical certifié, elle n’est pas soumise au HIPAA (loi de protection des données de santé).

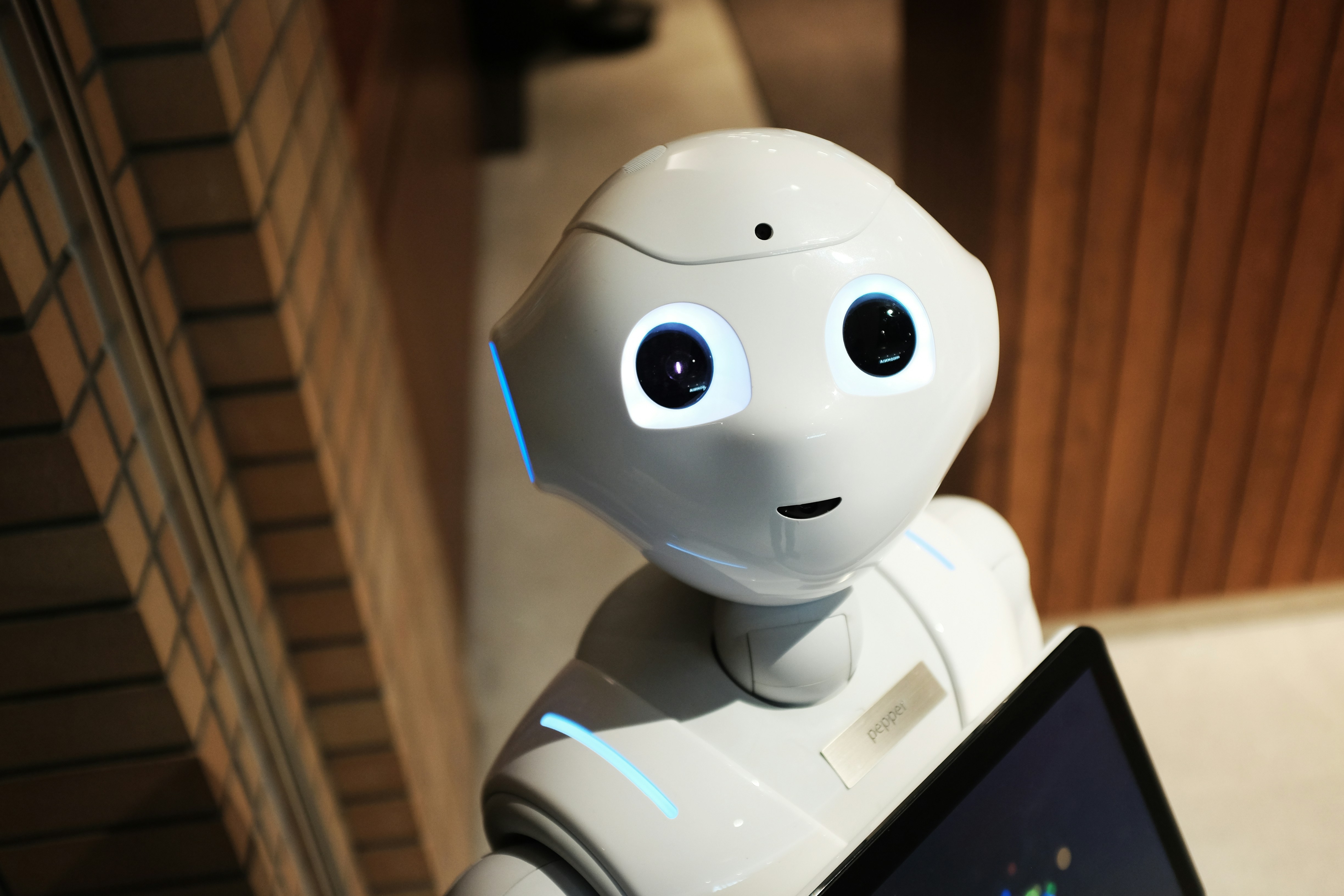

IA = écoute ? Oui. Thérapie ? Non.

Une IA peut soulager temporairement,

Donner l’illusion d’être comprise,

T’aider à formuler ton mal-être.

Mais attention :

Elle ne diagnostique pas,Elle ne gère pas les urgences psychiques,

Et elle capte tes données personnelles IA thérapie pour devenir plus performante.

Tu crois parler à un psy. En réalité, tu aides une IA à s’entraîner sur ta vulnérabilité.

Ce que tu confies peut t’échapper

ChatGPT, Replika ou Woebot n’oublient pas ce que tu dis — sauf si tu règles ça toi-même.

Tes émotions deviennent des données personnelles IA thérapie, potentiellement exploitables.

Le droit avance, mais reste flou sur cette zone hybride entre technologie et santé mentale.

Avant de confier ton mal-être à une IA, pose-toi cette question :

Cherches-tu un soutien... ou donnes-tu de la matière à un système qui ne te connaît pas ?

FAQ – Données personnelles, IA et thérapie

1. Est-ce que mes messages à une IA sont confidentiels ?

Non. À moins que l’application ne garantisse explicitement la confidentialité, tes données peuvent être utilisées pour entraîner l’IA.

2. Est-ce légal que l’IA stocke mes données personnelles IA thérapie ?

Cela dépend : en Europe, le RGPD s’applique. Mais si l’outil est hébergé hors UE (comme aux USA), les règles changent.

3. Une IA peut-elle remplacer un psychologue ?

Non. Elle peut soulager ou accompagner, mais elle ne remplace ni un diagnostic ni un suivi thérapeutique.

4. Peut-on empêcher une IA comme ChatGPT de garder nos messages ?

Oui. Il faut désactiver l’historique des discussions dans les paramètres.

5. Que faire si je me sens mal psychologiquement ?

L’IA peut être un outil de premier recours, mais il est essentiel de se tourner vers un professionnel de santé mentale.

Si vous traversez une période difficile, ne restez pas seul face à la machine. Parlez-en à un professionnel de santé mentale. En France, le 3114 est une ligne d’écoute gratuite, confidentielle et disponible 24h/24 pour toute situation de mal-être psychologique, de détresse ou de crise suicidaire.

Auteur : Simon Nguene