Tracking émotionnel : le prochain cauchemar du marketing ?

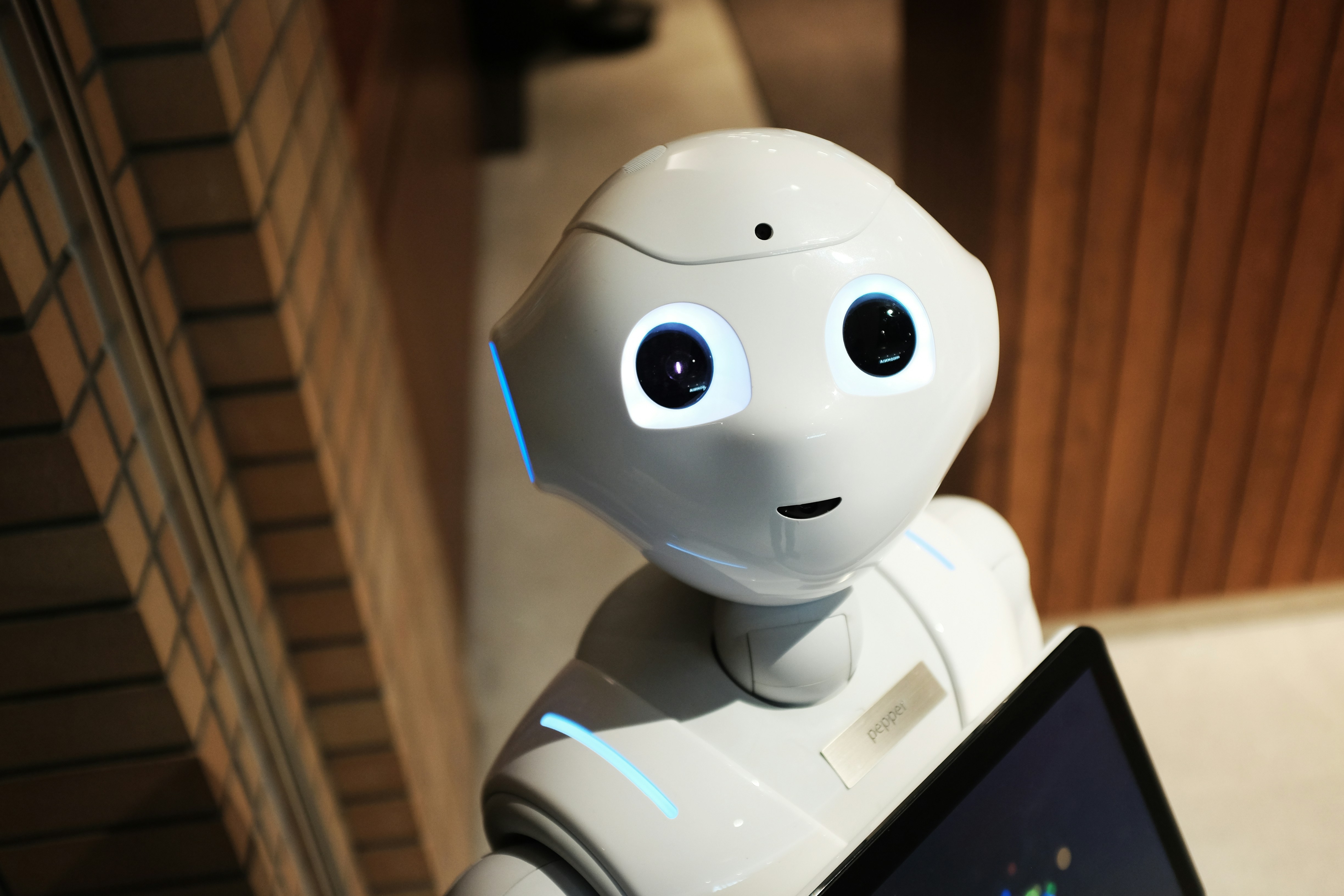

Vers une publicité qui lit nos émotions

Imaginez une publicité qui change de ton selon votre humeur. Vous souriez ? Le ton devient joyeux. Vous froncez les sourcils ? Le message s’adoucit. Ce n’est plus de la science-fiction. Le tracking émotionnel – ou reconnaissance émotionnelle – est en train de s’installer dans les outils du marketing digital. Grâce à des capteurs, des caméras et des algorithmes d’analyse, certaines entreprises prétendent désormais pouvoir lire nos émotions en temps réel, pour mieux adapter leur discours commercial. Mais à quel prix ? Derrière cette promesse de personnalisation ultime, des questions majeures surgissent sur la vie privée, le consentement, et les dérives potentielles de ces technologies encore peu encadrées.

Qu’est-ce que le tracking émotionnel ?

Le tracking émotionnel désigne un ensemble de technologies capables de détecter, analyser et interpréter nos émotions à partir de signaux biométriques. Cela peut inclure la reconnaissance faciale (micro-expressions, dilatation des pupilles, angle de votre sourire), l’analyse vocale (intonation, rythme), ou encore le suivi gestuel. Ces outils sont déjà expérimentés dans des contextes variés : publicités interactives en magasin, campagnes vidéo A/B testées sur les réactions faciales, ou entretiens RH assistés par IA. Des entreprises comme Affectiva, RealEyes, ou encore Microsoft avec son Emotion API proposent des solutions clé-en-main pour capter ces “signaux faibles” censés révéler l’état émotionnel du sujet. La promesse est claire : mieux comprendre les consommateurs pour mieux les convaincre.

Le rêve marketing : comprendre pour mieux vendre

Pour les annonceurs, le tracking émotionnel ouvre une voie vers un marketing encore plus ciblé, contextuel et réactif. En comprenant l’état d’esprit d’un utilisateur, une marque peut théoriquement ajuster son message à la volée : apaiser une frustration, renforcer une excitation, calmer une peur. On entre ici dans une ère où le consommateur ne dit plus ce qu’il ressent, il le montre sans le savoir. Mais cette précision émotionnelle soulève de nombreuses inquiétudes. Car en identifiant les vulnérabilités émotionnelles, on risque de manipuler les réactions, d’exploiter des failles psychologiques, et de transformer les émotions humaines en simples KPI marketing. Jusqu’où peut-on aller sans franchir la ligne rouge de l’éthique ?

Des limites techniques… et éthiques

Malgré l’enthousiasme des acteurs tech, le tracking émotionnel est encore loin d’être une science exacte. Les émotions sont hautement contextuelles, culturelles et ambigües. Un sourire ne signifie pas toujours la joie, une voix tremblante n’est pas forcément signe de peur. Les systèmes d’analyse sont souvent biaisés, particulièrement vis-à-vis des personnes racisées ou neuroatypiques, comme l’ont démontré plusieurs études universitaires. Plus grave encore, ces technologies sont parfois utilisées sans consentement explicite, dans des contextes sensibles comme l’éducation, les assurances ou le recrutement. Le risque ? Une normalisation de la surveillance émotionnelle, où l’expression des sentiments devient un terrain d’évaluation ou de contrôle.

Que dit le droit ?

Le Règlement général sur la protection des données (RGPD) classe les données biométriques comme des données sensibles, nécessitant un consentement renforcé. Or, l’analyse émotionnelle repose souvent sur l’observation de ces données : expressions du visage, tonalité de la voix, rythme respiratoire. À ce titre, le tracking émotionnel peut tomber sous le coup de l’article 9 du RGPD. La CNIL (en France) et le Comité européen de la protection des données (CEPD) ont d’ailleurs alerté sur les usages de ces technologies dans des contextes à fort déséquilibre de pouvoir (travail, école, santé). Dans certains cas, comme en Chine ou aux Émirats, ces systèmes sont déjà utilisés à des fins de contrôle social. En Europe, si le cadre existe, il reste fragile et mal appliqué, faute de jurisprudence et de contrôle effectif.

Conclusion : Vers une régulation du ressenti ?

Le tracking émotionnel cristallise les dérives d’un numérique toujours plus intrusif. Il ne s’agit plus seulement de ce que l’on fait ou dit, mais de ce que l’on ressent, parfois à notre insu. Si la technologie continue d’avancer plus vite que le droit, il devient urgent de poser des limites claires : interdiction dans certains contextes, obligation de transparence, contrôle indépendant des outils. Le marketing peut-il rester éthique quand il commence à anticiper nos réactions avant même que nous en soyons conscients ? C’est la question à laquelle devront répondre les régulateurs, mais aussi les entreprises et les citoyens. Car dans un monde où tout est mesurable, peut-être faut-il aussi revendiquer le droit au flou émotionnel.