algorithmes d'État : notation sociale, décisions automatisées

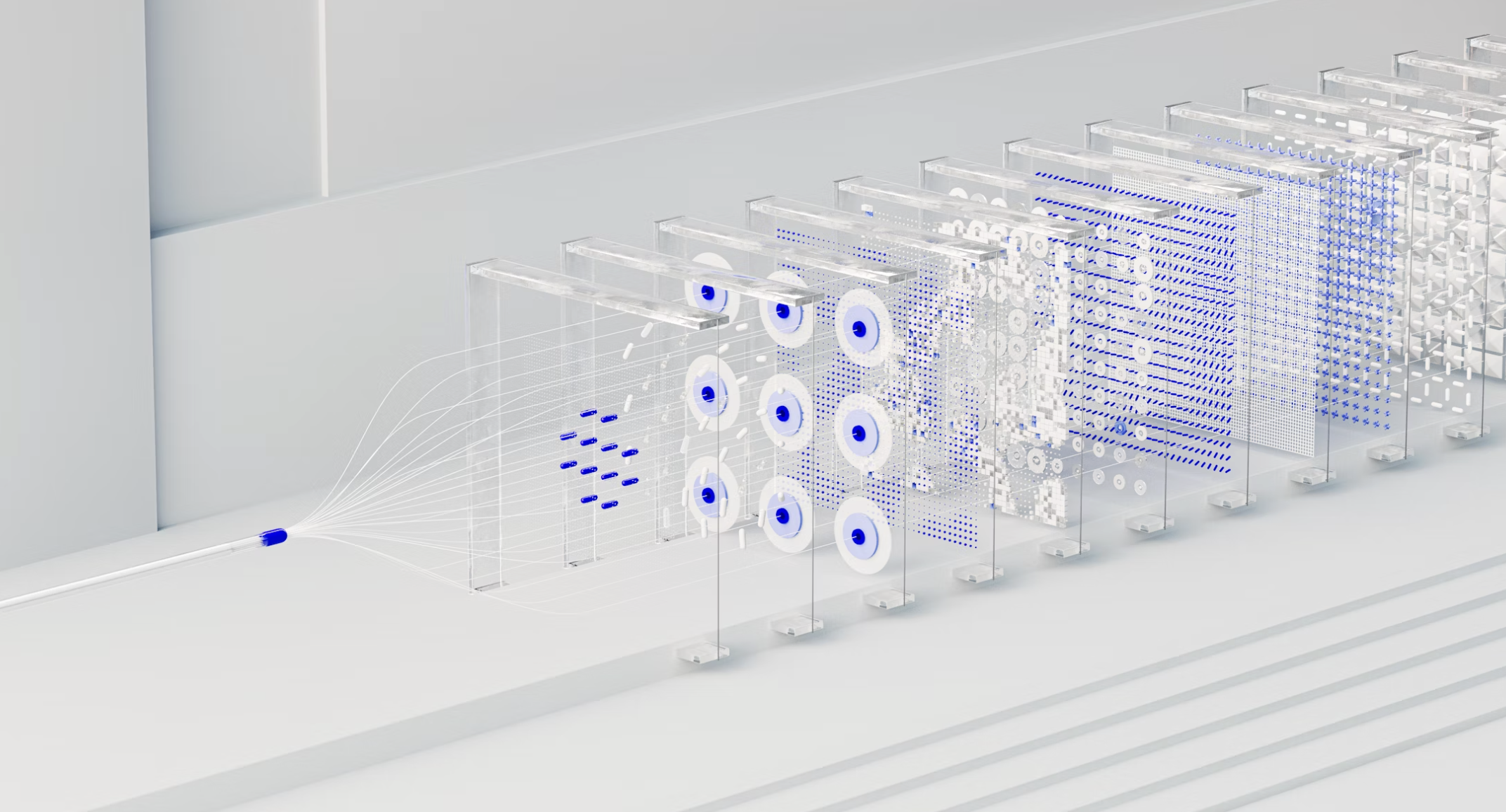

Algorithmes d’État : ce syntagme désigne l’ensemble des dispositifs numériques par lesquels la puissance publique mesure, classe, priorise et parfois tranche des situations individuelles. Au‑delà de l’innovation technique, il s’agit d’un changement d’architecture de la décision : des règles et des modèles statistiques, entraînés sur des données administratives, produisent des signaux qui peuvent redistribuer l’accès aux droits, orienter des parcours ou déclencher des contrôles. La promesse est celle d’une administration plus cohérente et plus efficiente ; le risque, celui d’une normalisation silencieuse où l’arbitraire migre du guichet vers la boîte noire.

L’enjeu n’est donc pas de « pour » ou « contre » l’automatisation, mais de savoir à quelles conditions ces algorithmes d’État sont légitimes, justes et gouvernables : base légale, nécessité et proportionnalité, qualité et représentativité des données, supervision humaine effective, explicabilité utile au citoyen, traçabilité et voies de recours réelles. Ce texte propose une grille d’analyse transdisciplinaire, droit, sciences sociales et ingénierie, pour distinguer la notation sociale fantasmée des usages réels, identifier les risques concrets et formuler un blueprint opérationnel de gouvernance publique des systèmes algorithmiques.

Problématique centrale : comment institutionnaliser des algorithmes d’État qui soient légitimes (base légale, finalité, proportionnalité), efficaces (robustesse, précision, calibration), justes (non‑discrimination, dignité, égalité), redevables (explicabilité, traçabilité, voies de recours), gouvernables (surveillance humaine réelle, auditabilité, amélioration continue) ?

Algorithmes d’État : clarifications conceptuelles

Décision automatisée vs aide à la décision

- Décision entièrement automatisée : le système détermine seul l’issue. Dans le cadre européen, l’article 22 RGPD confère un droit de ne pas faire l’objet d’une telle décision lorsqu’elle produit des effets juridiques ou similaires.

- Aide à la décision : le système fournit une recommandation ; un humain dûment formé conserve un pouvoir effectif de déviation (et la responsabilité). Sans **revue humain

Algorithmes d’État : définitions et distinctions utiles

Par algorithmes d’État, il faut entendre tout traitement automatisé destiné à éclairer ou à déterminer une décision administrative individuelle. La notion recouvre à la fois des systèmes fondés sur des règles explicites et des systèmes d’apprentissage statistique. Il convient de distinguer la décision entièrement automatisée, par laquelle l’issue est fixée par le traitement sans intervention humaine, et l’aide algorithmique à la décision, dans laquelle l’agent conserve un pouvoir effectif de déviation et la responsabilité de l’issue. Cette distinction n’est pas purement technique. Elle emporte des conséquences juridiques directes quant aux droits de la personne et aux obligations d’information.

La notation sociale doit être entendue comme l’attribution, par une autorité publique, d’une évaluation ou d’un classement susceptibles d’entraîner des effets concrets. En pratique, les administrations recourent moins à un score unique qu’à des ensembles de listes, d’indicateurs et de règles qui déclenchent des priorisations, des contrôles ou des refus. Cette architecture peut produire un effet de liste durablement défavorable si elle n’est pas assortie de mécanismes de correction et de recours effectifs.

Algorithmes d’État : cadre juridique positif

Le régime européen organisé par le règlement général sur la protection des données consacre un droit de ne pas faire l’objet d’une décision fondée exclusivement sur un traitement automatisé produisant des effets juridiques ou affectant de manière significative la personne. Ce droit s’accompagne d’exigences d’information, d’une possibilité d’intervention humaine, d’un droit à une explication significative de la logique sous‑jacente et d’un droit à la contestation. En droit français, le code des relations entre le public et l’administration impose que l’utilisation d’un traitement algorithmique ayant fondé une décision individuelle soit portée à la connaissance de l’intéressé et que lui soient communiquées, à sa demande et sous une forme intelligible, les règles et caractéristiques essentielles du traitement, notamment la nature des données employées, leur source, les paramètres principaux et le degré de contribution du traitement à la décision finale.

À l’échelle de l’Union, l’AI Act opère une interdiction ciblée des systèmes de notation sociale mis en œuvre par les autorités publiques et soumet de nombreux usages administratifs à un régime de haut risque. Ce régime exige une gouvernance documentée des données, une surveillance humaine, une gestion des incidents, un enregistrement auprès des autorités compétentes et une évaluation de conformité avant mise en service. Il en résulte que la légalité d’un algorithme d’État ne se mesure pas seulement à la régularité de sa conception, mais aussi à l’organisation pérenne de son contrôle.

Algorithmes d’État : principes directeurs dégagés du droit et de la jurisprudence

L’analyse conjointe du RGPD, du CRPA et de l’AI Act permet d’énoncer plusieurs principes. En premier lieu, la décision automatisée doit demeurer l’exception et ne se justifie que lorsqu’elle repose sur une base légale précise et qu’elle s’avère nécessaire au regard de la finalité poursuivie. En second lieu, l’information de l’administré doit être réelle et utile. La simple mention d’un recours à un traitement ne suffit pas si elle ne s’accompagne pas d’une explication intelligible des paramètres déterminants et de la place exacte du traitement dans le raisonnement administratif. En troisième lieu, la supervision humaine ne peut être purement formelle. L’agent appelé à décider doit être en situation de comprendre le signal, de l’apprécier au regard du contexte et de s’en écarter, le cas échéant, en laissant trace de sa motivation. En dernier lieu, l’exigence de proportionnalité commande une appréciation concrète de l’atteinte portée aux droits et libertés au regard du bénéfice attendu pour l’intérêt général, appréciation qui doit intégrer l’existence d’alternatives moins intrusives.

Algorithmes d’État : analyse des risques systémiques

Les algorithmes d’État exposent l’action publique à des risques qui ne se réduisent pas à l’erreur technique. La portance discriminatoire de certaines variables, même lorsqu’elles ne sont pas sensibles en elles‑mêmes, peut entretenir des effets différenciés selon les groupes sociaux. L’opacité de certains modèles, jointe à la protection légitime de secrets industriels, peut conduire à une asymétrie d’information prohibitive pour l’exercice effectif des droits. La logique de liste, lorsqu’elle alimente des contrôles répétés, tend à figer les positions et à produire des cascades de désavantages. S’ajoutent le refroidissement social, par lequel les individus se conforment par crainte de la visibilité, et la dépendance à des données historiques qui, si elles sont biaisées, ancrent l’injustice au cœur du dispositif. La prévention de ces risques suppose des mécanismes spécifiques d’identification, de mesure et de remédiation, intégrés au cycle de vie du système.

Algorithmes d’État : enseignements tirés de quelques affaires

L’invalidation du système néerlandais SyRI par la juridiction compétente illustre l’exigence d’une proportionnalité vérifiable. Le dispositif, conçu pour repérer des fraudes sociales, s’est avéré excessivement intrusif au regard de garanties insuffisantes et d’une opacité incompatible avec le niveau d’atteinte à la vie privée. L’affaire a rappelé que la seule invocation d’un objectif d’intérêt général ne suffit pas à purger un dispositif de ses vices lorsque la méthode et la publicité font défaut.

Le cas français de Parcoursup a, quant à lui, souligné la nécessité d’articuler autonomie des formations et transparence procédurale. La reconnaissance d’algorithmes locaux a conduit à exiger une publicité a posteriori des critères effectivement employés. Cette publicité ne vise pas à révéler des secrets pédagogiques, mais à permettre au candidat d’apprécier la logique de classement qui a influé sur son sort.

L’épisode britannique de la standardisation algorithmique des notes d’examen en 2020 a enfin montré que la validité statistique d’un modèle à l’échelle agrégée peut se traduire par une injustice manifeste à l’échelle individuelle. La perte de confiance qui s’ensuit compromet la légitimité de l’action. L’enseignement principal est que la précision moyenne ne saurait tenir lieu de justice procédurale et qu’une capacité de correction rapide doit être prévue.

Jurisprudence et contentieux récents

Pays‑Bas (affaire SyRI, 5 février 2020) : le tribunal de La Haye a censuré le système SyRI de détection de fraude sociale, retenant une ingérence disproportionnée dans la vie privée et un défaut de transparence. Cette décision illustre l’exigence européenne de proportionnalité et d’explicabilité des dispositifs de profilage déployés par l’administration.

France (Parcoursup, décision n° 2020‑834 QPC, 3 avril 2020) : le Conseil constitutionnel a levé partiellement le voile sur les « algorithmes locaux » utilisés par les établissements, en consacrant l’obligation de publication a posteriori des critères ayant fondé l’examen des candidatures et, le cas échéant, l’usage d’un traitement algorithmique. Le juge constitutionnel réaffirme ainsi la primauté du contrôle humain et la redevabilité des décideurs publics.

Royaume‑Uni (Ofqual, été 2020) : la standardisation algorithmique des notes du secondaire a conduit à un abaissement massif des notes prédites (de l’ordre de 36 à 39 % des propositions enseignantes), suscitant une révision généralisée et une prise de conscience des limites de la modélisation historique en contexte d’hétérogénéité sociale. L’épisode rappelle que la « robustesse statistique » ne saurait suppléer les garanties procédurales (explicabilité, voies de recours, contrôle humain effectif).

Autriche (AMS/AMAS, 2020–2025) : l’autorité de protection des données a interdit en 2020 l’usage d’un algorithme de profilage des demandeurs d’emploi, faute de base légale suffisante et en raison d’un risque d’atteinte aux droits (art. 22 RGPD). En 2025, la cour administrative fédérale a annulé cette interdiction en relevant l’existence d’un contrôle humain substantiel ; le projet est néanmoins demeuré caduc après suppression des données. L’affaire illustre l’axe central du contentieux européen : le critère d’« intervention humaine significative ».

Données empiriques et doctrines utiles au juge

Effets dissuasifs (« chilling effects ») : des travaux empiriques montrent une baisse statistiquement significative de la consultation de contenus sensibles après la révélation de programmes de surveillance étatique ; cette dynamique renseigne le juge sur l’atteinte autonome à la liberté d’information que peut générer un environnement de notation/profilage.

Biais d’automatisation et confiance : la littérature en facteurs humains établit un double risque de sur‑confiance (erreur de commission) et de sous‑confiance (erreur d’omission) envers les aides algorithmiques ; l’explicabilité contextuelle et la formation des agents réduisent ces effets, mais ne les annulent pas. D’où l’exigence d’un contrôle humain « effectif et non symbolique ».

Théorie de l’égalité et des métriques de justice : en sciences des données, les critères de « fairness » sont en tension ; il est mathématiquement impossible d’optimiser simultanément certaines propriétés (calibration inter‑groupes, égalisation des taux d’erreur, parité démographique) dès lors que les prévalences diffèrent. Le droit doit donc expliciter, au cas d’espèce, la hiérarchie des objectifs (non‑discrimination vs. précision) et motiver les arbitrages.

Administrations sociales (exemples français) : les débats récents sur le scoring antifraude (CNAF, CNAM) révèlent des risques de discrimination indirecte par l’usage de variables socio‑démographiques et posent la question de la proportionnalité et de la preuve d’efficacité (différences limitées de taux « d’anomalies » détectées). Ces dossiers confirment l’utilité d’évaluations d’impact ex ante et d’audits indépendants ex post.

Algorithmes d’État : gouvernance et garanties procédurales

La conformité d’un dispositif ne se résume pas à une liste d’obligations. Elle suppose l’édification d’une véritable procédure contradictoire adaptée à l’automatisation. Un registre public d’algorithmes, aisément accessible, décrit pour chaque système sa finalité, sa base légale, les catégories de données mobilisées, la logique de traitement dans ses grandes lignes, les paramètres principaux et les modalités de supervision. Une évaluation d’impact, conduite en amont et mise à jour à intervalles réguliers, expose les risques identifiés, les mesures de mitigation et les résultats de tests d’équité. La notification adressée à l’administré précise le degré de contribution du traitement à la décision et ouvre la voie à une explication personnalisée lorsque l’issue lui est défavorable. La supervision humaine est organisée pour être effective. Elle repose sur la formation des agents, sur la disponibilité de temps suffisant pour l’examen et sur la possibilité, réellement exercée, d’écarter la recommandation algorithmique, la motivation étant conservée dans un journal accessible au contrôle. La traçabilité, enfin, assure l’intégrité du raisonnement. Les versions de modèles, les seuils applicables et les principales raisons ayant conduit à l’issue sont documentés de manière à permettre un audit indépendant et, le cas échéant, le contrôle du juge.

Algorithmes d’État : méthodologie de contrôle et d’audit

Le contrôle des algorithmes d’État gagne à être pensé comme une suite ordonnée d’examens. Le cadrage juridique identifie la finalité, la base normative et les parties prenantes responsables. La cartographie décisionnelle indique la place exacte du traitement dans la chaîne de décision et les seuils à partir desquels une recommandation devient déterminante. L’inventaire des données établit leur provenance, leur qualité et leur représentativité. La reproductibilité du dispositif est vérifiée par la documentation des versions et des paramètres. La performance est évaluée en tenant compte des coûts sociaux des erreurs et non des seules métriques globales. L’équité est mesurée au travers d’indicateurs explicites qui sont interprétés à la lumière des contextes locaux. L’explicabilité est appréciée au double niveau global et individuel, l’administration devant être en mesure d’exposer au citoyen les facteurs principaux qui ont pesé dans son cas. La robustesse est éprouvée par des tests de résistance et par une surveillance des dérives dans le temps. La supervision humaine est auditée dans son effectivité. La journalisation est contrôlée sous l’angle de sa complétude et de sa conservation. Chaque audit donne lieu à un rapport public, accompagné d’un résumé non technique, qui expose les limites et les actions correctrices.

Algorithmes d’État : droits des administrés et voies de recours

La personne concernée par un algorithme d’État doit pouvoir exercer ses droits de manière aisée et rapide. Elle est informée, au moment pertinent, de l’existence d’un traitement et de son rôle dans la décision. Elle peut accéder à ses données, en demander la rectification et solliciter une explication de la logique déterminante. Lorsqu’une décision est fondée exclusivement sur un traitement automatisé, elle peut exiger l’intervention d’un agent, obtenir un réexamen et contester l’issue par les voies ordinaires du contentieux administratif. L’effectivité de ces droits dépend de l’organisation d’un guichet identifié, des délais raisonnables de réponse et de la capacité de l’administration à produire une motivation intelligible. À défaut, la protection proclamée demeure théorique et illusoire.

Les algorithmes d’État ne sont pas illégitimes par nature. Ils le deviennent lorsqu’ils substituent à la justification publique une opacité technique, lorsqu’ils naturalisent des inégalités sous couvert de neutralité et lorsqu’ils transforment l’exception de l’automatisation en règle de gestion. Un État algorithmique compatible avec l’État de droit est un État qui sait justifier ses choix, qui accepte l’audit et la contradiction, qui organise l’erreur pour mieux la corriger et qui garantit à chacun la possibilité d’être entendu. La modernisation ne vaut que si elle demeure gouvernée par le droit et ordonnée à la dignité des personnes. À ces conditions, les algorithmes d’État peuvent devenir des instruments de meilleure administration plutôt que des machines à classer les vies.

Pour un approfondissement des biais algorithmiques en contexte judiciaire, voir l’article « Les biais algorithmiques en justice » publié sur le site CtrlZed Media.

Références

Droit de l’Union et droit français :

- RGPD, art. 22 (décision individuelle automatisée) et art. 15(1)(h) (accès aux « informations utiles ») ; version JOUE/EUR‑Lex.

- CRPA, art. L.311‑3‑1 (mention explicite) et art. R.311‑3‑1‑2 (contenu de l’information) ; Legifrance.

- AI Act, art. 5 (pratiques interdites, notation sociale) ; texte EUR‑Lex.

Jurisprudence et affaires :

- Pays‑Bas, SyRI (The Hague District Court, 5 févr. 2020) — violation du droit au respect de la vie privée et défaut de transparence.

- France, décision n° 2020‑834 QPC (3 avr. 2020) — Parcoursup et publicité des critères/algorithmes locaux a posteriori.

- R.-U., Ofqual (2020) — standardisation algorithmique des notes (≈ 36–39 % de baisses des notes prédites) et revirement.

- Autriche, AMS/AMAS (2020–2025) — interdiction DPA puis annulation par la cour administrative au regard du contrôle humain.

Gouvernance :

- Directive canadienne sur la prise de décision automatisée et AIA (impact levels I–IV, obligations graduées).

- Registres d’algorithmes : Amsterdam ; Helsinki ; Standard de transparence d’Eurocities.

Recherches et doctrine :

- Penney (2016) — chilling effects sur la consultation de contenus sensibles après révélations de surveillance.

- Parasuraman & Riley (1997) ; Dzindolet et al. (2002–2003) ; Goddard et al. (2011) — biais d’automatisation et rôle de l’explication.

- Hardt, Price, Srebro (2016) ; Kleinberg, Mullainathan, Raghavan (2016) ; Chouldechova (2017) — tensions structurelles entre métriques de justice et impossibilités d’optimisation conjointe.

Pour une perspective approfondie sur la façon de détecter et de réduire les biais algorithmiques dans l’action publique, voir l’article du Brookings Institution intitulé « Algorithmic bias detection and mitigation: Best practices and policies to reduce consumer harms ».

Qu’est-ce qu’un algorithme d’État ?

Un algorithme d’État est un système automatisé, souvent fondé sur des règles ou sur l’apprentissage statistique, conçu pour assister ou déterminer une décision administrative. Il peut concerner l’attribution de prestations, la détection de fraude, l’orientation scolaire, la sécurité ou la santé publique. Il n’existe pas un algorithme unique géré par l’État mais une pluralité de traitements soumis au droit public et à la protection des données personnelles.

Les algorithmes d’État sont-ils légaux ?

Oui, à condition qu’ils respectent le principe de légalité et les garanties procédurales. Le RGPD (article 22) interdit les décisions entièrement automatisées produisant des effets juridiques, sauf si elles reposent sur une base légale claire et comportent des garanties spécifiques. En droit français, le Code des relations entre le public et l’administration impose la mention explicite de tout traitement algorithmique ayant concouru à une décision et la communication, sur demande, de ses caractéristiques essentielles.

Quelle est la différence entre une aide à la décision et une décision automatisée ?

L’aide algorithmique éclaire la décision sans la déterminer. L’agent public conserve la faculté de s’écarter du résultat, d’en apprécier la pertinence et d’en justifier la déviation. À l’inverse, une décision automatisée fixe l’issue sans intervention humaine réelle, ce qui déclenche les droits à l’intervention humaine, à l’explication et à la contestation.

Quels sont les droits du citoyen face à un algorithme d’État ?

Tout citoyen a droit à l’information sur l’existence d’un traitement algorithmique, à la connaissance de ses règles principales et à l’accès aux données le concernant. Il peut demander une explication intelligible de la logique employée, exiger une intervention humaine et contester une décision exclusivement automatisée. Ces droits sont garantis par le RGPD, le CRPA et, à terme, par l’AI Act.

L’administration doit-elle publier le code source ?

Non. Le droit n’impose pas la communication du code source mais celle des règles et caractéristiques essentielles. L’objectif est d’assurer une compréhension suffisante de la logique du traitement. Le secret des affaires peut justifier certaines restrictions mais il ne peut pas anéantir le droit à une information utile et intelligible.

Qu’est-ce qu’un registre public d’algorithmes ?

Il s’agit d’un inventaire accessible au public recensant les traitements utilisés par les administrations, leur finalité, leur base légale, leurs données, leurs paramètres principaux et les voies de recours. Amsterdam, Helsinki ou encore le Canada ont déjà mis en place de tels registres, qui renforcent la transparence et la confiance.

Quels sont les principaux risques ?

Les risques tiennent aux biais de données, à l’opacité, à la discrimination indirecte et à l’absence de supervision humaine. Le chilling effect — la peur d’être surveillé — peut conduire à une autocensure. Enfin, la dépendance à des données historiques biaisées risque de reproduire des inégalités passées. Ces risques justifient un contrôle humain, une documentation continue et des audits indépendants.

Que dit la jurisprudence européenne ?

Plusieurs affaires emblématiques illustrent ces exigences. Le tribunal de La Haye a invalidé en 2020 le système SyRI de détection de fraude sociale pour atteinte disproportionnée à la vie privée. Le Conseil constitutionnel français a rappelé, dans l’affaire Parcoursup, l’obligation de publicité des critères de sélection. Au Royaume-Uni, l’échec d’Ofqual en 2020 a montré qu’un modèle statistiquement performant peut être socialement injuste.

Quels garde-fous doivent être mis en place ?

Une administration responsable doit procéder à une évaluation d’impact ex ante, organiser la supervision humaine effective, assurer la traçabilité et publier les audits. Le principe de proportionnalité exige que chaque algorithme soit justifié par une nécessité avérée et qu’il existe des voies de recours effectives. La transparence et la possibilité de contradiction demeurent les meilleurs remparts contre la dérive vers une notation sociale.

Quelle est la finalité du contrôle juridictionnel ?

Le juge administratif veille à ce que l’automatisation ne compromette ni la légalité, ni la proportionnalité, ni la dignité des personnes. Il vérifie la base légale du traitement, la réalité de la supervision humaine et la clarté de l’information fournie à l’administré. En cela, le contrôle juridictionnel devient la garantie ultime de la compatibilité des algorithmes d’État avec l’État de droit.