Algorithmes de rencontre : quand l’IA choisit pour nous sur Tinder, Hinge et Bumble

Algorithmes de rencontre : comment Tinder et l’IA redéfinissent l’amour

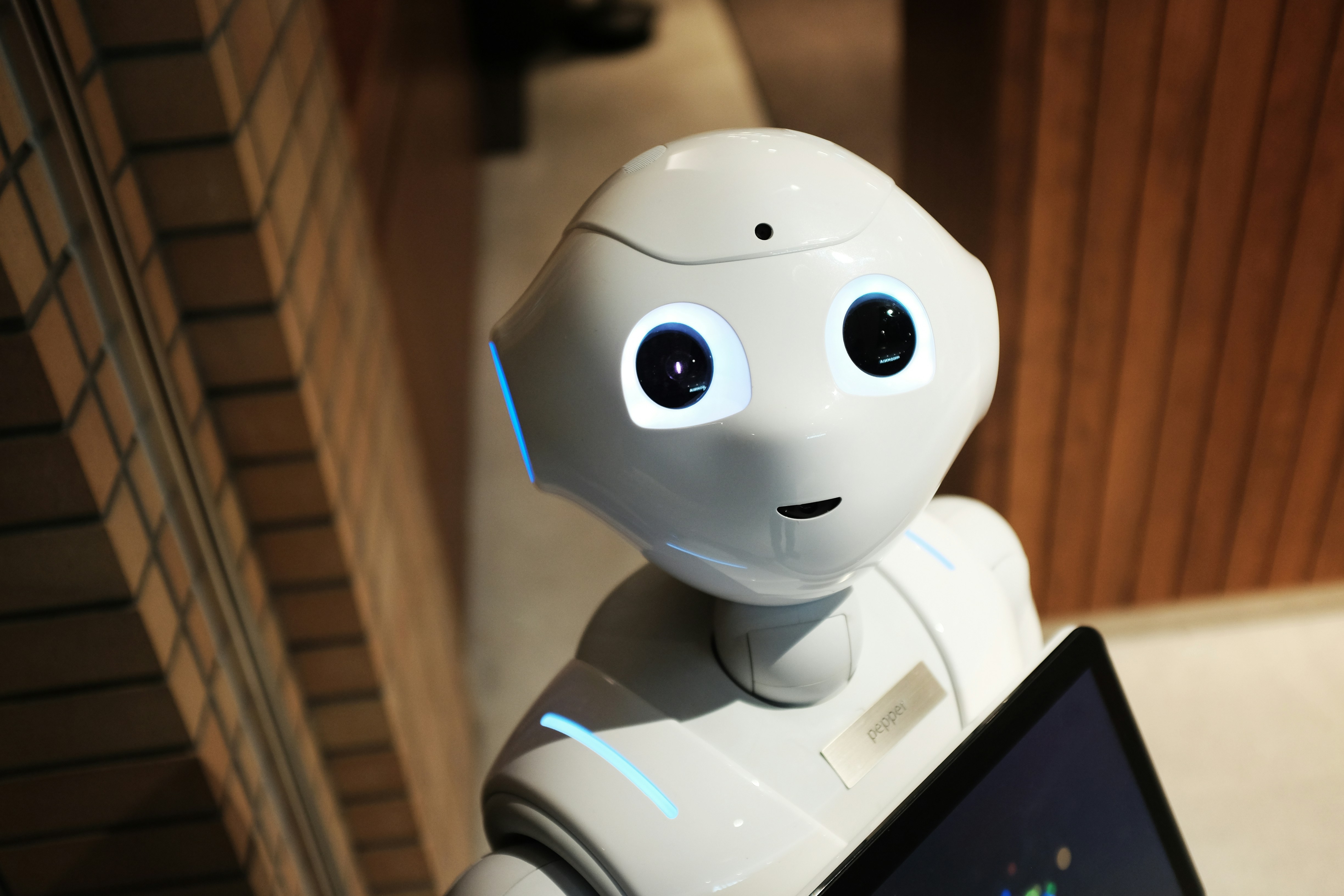

À l’ère des applications de dating, les algorithmes de rencontre bouleversent les relations humaines. Tinder, Bumble, Hinge ou encore Grindr n’ont pas simplement numérisé les échanges amoureux : ils ont introduit dans l’intime des logiques d’optimisation, de calcul, et de tri algorithmique. L’amour est-il encore une affaire de hasard quand l’intelligence artificielle prétend prédire qui vous plaira ? Que deviennent nos préférences… et nos données ? Au croisement du numérique, du social et du juridique, décryptage d’un phénomène aussi séduisant qu’inquiétant.

L’amour sous algorithme : la mécanique des apps de rencontre

Les algorithmes de rencontre reposent sur une combinaison de données déclaratives (âge, genre, orientation), de comportements analysés (temps passé sur les profils, "swipes", messages), et de préférences inférées (niveau d’attractivité, goûts supposés).

Certaines IA vont plus loin : elles analysent les photos, les textes de bio, les emojis utilisés, pour évaluer la compatibilité potentielle. Ce ne sont donc plus seulement vos choix qui comptent, mais ce que l’algorithme pense que vous allez aimer. En somme, nous ne "matchons" plus librement — nous sommes aussi sélectionnés, catégorisés, et orientés par des logiques opaques.

🧠 À lire aussi sur CtrlZed : Tracking émotionnel : le prochain cauchemar du marketing ?

Biais sociaux ou tri algorithmique ?

Loin d’être neutres, les algorithmes de rencontre reproduisent — et parfois accentuent — les discriminations sociales. Plusieurs études (notamment sur OKCupid et Tinder) montrent que :

- Les utilisateurs blancs sont plus souvent "matchés" que les utilisateurs racisés,

- Les profils correspondant aux normes de beauté dominantes (minceur, jeunesse, taille) sont surreprésentés,

- Les algorithmes favorisent l’homogamie sociale (niveau d’études, catégorie socio-professionnelle).

Ce n’est plus seulement l’amour qui s’exprime, mais une standardisation algorithmique du désir, comme l'explique cet article de The Conversation.

Opaque par défaut : une transparence en trompe-l’œil

Le RGPD impose pourtant des garde-fous :

- Le droit à l’information sur le fonctionnement des algorithmes,

- Le droit d’accès et de rectification des données,

- Le droit à ne pas faire l’objet d’une décision automatisée sans intervention humaine (article 22).

Mais dans les faits, ces plateformes n'expliquent pas comment elles décident des profils visibles, ni pourquoi certains profils sont montrés plus que d'autres. Et les préférences sensibles (religion, orientation sexuelle, origine) sont souvent traitées sans transparence.

Données sensibles et consentement : un équilibre précaire

Les apps de rencontre traitent des données particulièrement intimes, relevant de l’article 9 du RGPD : sexualité, préférences, pratiques religieuses, etc. Leur traitement suppose :

- Un consentement explicite,

- Des garanties de sécurité renforcées,

- Une finalité claire et légitime.

Or, les CGU sont rarement lues, et les utilisateurs ignorent souvent que leurs données peuvent être revendues à des tiers ou utilisées à des fins publicitaires.

Quand l’algorithme devient juge de l’amour

Les algorithmes de rencontre, en catégorisant les individus, peuvent aussi perpétuer des formes de discrimination numérique. En France, la CNIL rappelle que les traitements automatisés ne peuvent justifier une inégalité fondée sur l’origine, le sexe ou l’orientation.

Au niveau européen, le règlement sur l’intelligence artificielle (AI Act) envisage de classer certains systèmes comme "à haut risque", notamment ceux qui influencent les comportements sociaux. Les outils de "matching" pourraient bientôt entrer dans cette catégorie.

Séduits… mais surveillés ?

Les algorithmes de rencontre ont facilité l’accès à l’amour — mais ils l’ont aussi modélisé, quantifié, encadré. À mesure que les applications s’immiscent dans l’intime, le droit doit jouer un rôle central : non pas freiner l’innovation, mais garantir que les logiques algorithmiques respectent nos libertés fondamentales.

L’amour ne devrait pas être une ligne de code opaque. Il mérite un traitement à la hauteur de sa complexité humaine.

FAQ – Algorithmes de rencontre et protection des données

1. Les applications de rencontre peuvent-elles revendre mes données ?

Oui, si vous avez donné votre accord (souvent via les CGU). Certaines apps partagent vos données avec des partenaires publicitaires.

2. Comment savoir ce que l’algorithme "pense" de moi ?

C’est très difficile : les plateformes gardent le secret sur leurs algorithmes. Vous pouvez exercer un droit d’accès auprès du service concerné.

3. Puis-je refuser que l’IA décide pour moi ?

Oui. L’article 22 du RGPD vous permet de refuser une décision entièrement automatisée. Encore faut-il savoir qu’elle existe…

4. Les algorithmes de rencontre sont-ils discriminatoires ?

Ils peuvent l’être. Les biais humains sont souvent reproduits (voire amplifiés) dans les systèmes d’IA mal encadrés.

5. Que dit la loi française ?

La CNIL impose des obligations de transparence, de sécurité, et de non-discrimination. Elle peut sanctionner les abus.

Auteur : Simon Nguene