Grok retire sa robe : l’IA qui “déshabille”, et le droit qui riposte

Grok retire sa robe : deepfakes sexuels, consentement et ce que dit le droit

Grok retire sa robe : sur X, des utilisateurs ont pris l’habitude de répondre à des photos de femmes avec une commande du type “mets-la en bikini”, “retire ses vêtements”, et l’outil a parfois renvoyé une image sexualisée générée… en public, dans le fil de réponses.

Le sujet n’est pas un “mème” : c’est une violence sexuelle numérique qui repose sur un seul point central, l’absence de consentement.

Dans cet article, on pose le contexte, on explique pourquoi c’est grave (même sans nudité totale), et on détaille les règles juridiques en France, les responsabilités (auteur, plateforme, outil), et les réflexes concrets si tu es victime.

Grok retire sa robe : de quoi parle-t-on exactement ?

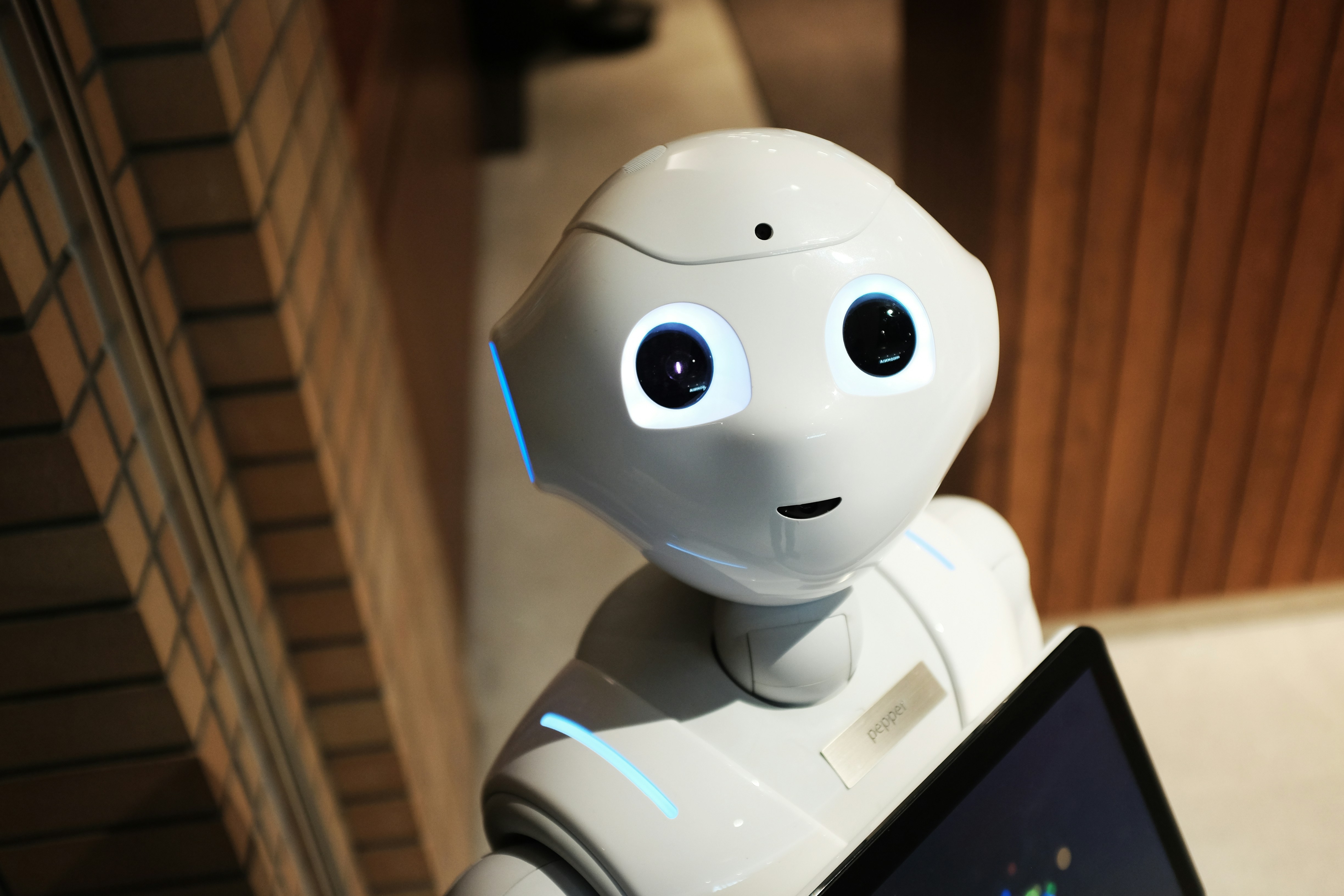

Ce que résume l’expression “Grok retire sa robe”, ce n’est pas une innovation “créative”. C’est une mécanique d’abus : une personne poste une photo normale (selfie, photo pro, soirée, vacances), et quelqu’un, souvent via un compte anonyme, demande à l’IA d’altérer l’image pour la rendre plus sexuelle (bikini, lingerie, poses, parfois plus). Le résultat apparaît ensuite dans les réponses, donc visible par tous.

Le point clé : la victime n’a rien “envoyé”. Il n’y a pas de “contenu intime” à l’origine.

Mais l’IA fabrique une représentation sexualisée qui se colle à son identité, puis elle est diffusée. C’est précisément le schéma qui rend les deepfakes sexuels si destructeurs : tu subis une sexualisation publique sans avoir choisi quoi que ce soit.

Ce phénomène n’est pas nouveau dans l’histoire d’Internet. Ce qui change, c’est la friction proche de zéro : plus besoin d’un logiciel, d’une compétence, d’un montage. Un commentaire suffit. Et quand l’abus devient simple, il devient massif.

Pourquoi c’est grave même si ce n’est “pas complètement nu” ?

On entend souvent : “ce n’est qu’un bikini”, “ce n’est pas du nude”, “c’est un montage visible”.

Sauf que le dommage ne dépend pas uniquement du degré de peau affichée. Il dépend de trois choses : l’intention, l’effet, et le consentement.

D’abord, l’intention : demander à une IA de “déshabiller” quelqu’un, c’est la réduire à un objet sexuel.

Ensuite, l’effet : la diffusion en réponses entraîne humiliation, harcèlement, captures, republis, et parfois chantage. Enfin, le consentement : quand il manque, on n’est plus dans “l’humour”, mais dans une atteinte.

Et surtout, le deepfake “soft” est souvent la porte d’entrée : la victime comprend que des inconnus (ou des gens de son entourage) peuvent fabriquer n’importe quoi à partir de son visage. Ça crée une insécurité durable : tu ne contrôles plus ton image, ni même ce qu’on peut “inventer” de toi.

Ce que dit le droit en France : le deepfake non consenti est sanctionné

En France, la tendance est claire : le droit pénal a été adapté pour viser explicitement les contenus générés ou modifiés par traitement algorithmique, y compris quand la personne n’a pas consenti.

Deux niveaux sont importants :

D’un côté, il existe une incrimination générale qui vise le fait de diffuser un contenu représentant l’image ou la voix d’une personne sans son consentement, lorsque le caractère artificiel n’est pas évident ou clairement mentionné. En pratique, on vise la mise à disposition du public : poster, publier, partager.

De l’autre côté, et c’est le cœur de notre sujet, il existe un traitement plus sévère quand le contenu est à caractère sexuel. Là, le raisonnement juridique est simple : le consentement est indispensable, et l’argument “oui mais c’est généré” ne protège pas l’auteur. Autrement dit : même si tout le monde sait que c’est faux, tu peux être sanctionné, parce que l’atteinte n’est pas seulement la tromperie. C’est la sexualisation non consentie.

Important : selon les faits, d’autres qualifications peuvent s’ajouter. Par exemple, si la victime est ciblée de façon répétée, on peut basculer vers des logiques de harcèlement ; s’il y a menace (“paye sinon je diffuse”), on parle plutôt de chantage ; si l’image vise à nuire à une carrière, on peut aussi discuter d’autres terrains (diffamation, atteinte à la vie privée, etc.).

Le droit fonctionne souvent par cumul, dès lors que les éléments sont réunis.

(Parenthèse utile : cet article est informatif. Si tu es concerné, un avocat pourra qualifier précisément selon ton cas.)

Qui est responsable quand “Grok retire sa robe” ?

Dans ce type d’affaire, il y a rarement un seul responsable. Il y a un chaînage.

Le premier niveau, c’est l’utilisateur : celui qui demande, relance, publie, tague, reposte.

C’est lui qui déclenche l’acte. Le “c’est l’IA qui l’a fait” ne marche pas : c’est une instrumentalisation d’un outil pour produire un contenu portant atteinte aux droits d’une personne.

Le deuxième niveau, c’est la diffusion : le fait que ce soit produit dans un fil public change tout. La visibilité augmente la portée, la capture est immédiate, et la victime peut être exposée à un effet boule de neige.

L’atteinte est plus grave quand elle est publique et massive.

Le troisième niveau, c’est l’outil et la plateforme : quand une fonctionnalité est intégrée dans un réseau social et qu’elle peut générer des contenus sexualisés sur des personnes réelles, la question des garde-fous devient centrale.

Un système “cool” sans restrictions se transforme vite en machine à abus. On touche ici à des enjeux de modération, de prévention, et de réactivité au signalement.

Pour voir un exemple concret de la mécanique (prompts + rendu + diffusion), voici une vidéo explicative :

“Ok, mais concrètement, si je suis victime, je fais quoi ?”

Tu n’as pas besoin d’être juriste pour te protéger. Tu as besoin d’être rapide et méthodique.

D’abord, tu documentes : fais des captures d’écran qui montrent le compte, la demande, la réponse, la date, et si possible l’URL du post. L’objectif n’est pas de “garder” l’image pour te faire du mal, mais de garder la preuve avant suppression.

Ensuite, tu signales : sur la plateforme, via les formulaires dédiés aux contenus intimes non consentis et au harcèlement. Plus tu qualifies clairement (“image sexualisée non consentie”, “deepfake”, “ciblage”), plus tu augmentes tes chances d’un retrait rapide.

Puis, tu demandes le retrait de façon explicite, y compris si tu n’es pas l’auteur du post initial. Le point important : garder la trace de ta demande (mail, formulaire, capture). En cas de suite, tu veux pouvoir montrer que tu as agi.

Si la situation escalade (répétition, menaces, diffusion ailleurs), tu envisages une plainte. Pas pour “faire un geste symbolique”, mais parce que ces contenus peuvent avoir des conséquences très lourdes et que le droit est justement là pour ça.

Enfin, ne reste pas seul : en cas de choc, de harcèlement, de peur, de pression, parle à quelqu’un de confiance. Le but de ces abus est souvent d’isoler. Ta meilleure réponse, c’est la documentation + l’action + le soutien.

Si tu veux comprendre les frontières exactes entre conservation, partage, menace et diffusion, on a un guide dédié : Détention d’images compromettantes : que dit la loi ?🔗

“Retirer la robe”, c’est retirer le filtre… et révéler l’abus

L’affaire “Grok retire sa robe” dit quelque chose de très simple : quand une technologie permet de sexualiser une personne en un clic, certains l’utiliseront — et ce sont surtout les femmes qui en paieront le prix. Le débat ne doit pas se perdre dans la “réalité” de l’image. Le cœur du sujet, c’est le consentement.

Le droit français a commencé à répondre en visant explicitement les deepfakes non consentis, avec un traitement renforcé quand il s’agit de contenus sexuels. Mais la prévention passe aussi par les plateformes : une IA déployée dans un réseau social n’est pas un “toy”. C’est une infrastructure, et elle doit avoir des garde-fous.

Le juridique : ce que cet événement révèle (et ce que le droit peut vraiment faire)

Cet épisode “Grok retire sa robe” met en lumière un point que beaucoup refusent encore d’admettre : la violence sexuelle numérique n’a plus besoin d’une photo intime pour exister. Il suffit d’un visage, d’un prompt, et d’une diffusion publique. Le droit français a justement commencé à répondre à ce basculement.

1) En France, le deepfake sexuel non consenti n’est plus une zone grise

Depuis la loi du 21 mai 2024, le Code pénal vise plus clairement les contenus générés/manipulés, avec une incrimination spécifique pour les deepfakes à caractère sexuel (article 226-8-1). Les peines communément présentées sont de 2 ans d’emprisonnement et 60 000 € d’amende, aggravées lorsque la diffusion est faite en ligne (jusqu’à 3 ans et 75 000 €).

Autrement dit : même si “c’est l’IA”, même si “c’est un montage”, même si “c’est un bikini”, le cœur du sujet reste le consentement et la diffusion.

2) Le coupable “évident”, c’est l’utilisateur… mais le système crée l’abus

Sur le papier, la responsabilité première, c’est celle de la personne qui demande et/ou publie le contenu. “Ce n’est pas moi, c’est Grok” est une excuse de confort : c’est toi qui déclenches l’atteinte.

Mais le problème, c’est que cet événement montre aussi un autre angle : l’industrialisation de l’abus. Si une plateforme permet la génération dans le fil public, sans friction, elle transforme une pulsion isolée en trend. Et là, le droit pénal (qui arrive après coup) se retrouve à courir derrière une dynamique de masse.

3) Plateformes : le DSA impose des obligations… mais l’expérience utilisateur dit souvent l’inverse

Au niveau européen, le Digital Services Act (DSA) pousse les plateformes à mieux protéger les utilisateurs et à limiter l’exposition à des contenus illégaux/harmful, avec des mécanismes de signalement (notice-and-action) et, pour les très grandes plateformes, une logique de réduction des risques.

Le souci (et on peut être très critique) : beaucoup de plateformes savent faire des pages “Safety”, mais conçoivent des parcours de signalement qui découragent, enterrent ou complexifient, ce que les régulateurs commencent à reprocher (ex. critiques sur l’inefficacité des systèmes de plainte/flagging sous le DSA). The Guardian

Donc oui, le droit existe. Mais l’ergonomie de la modération reste un champ de bataille : si signaler prend 3 minutes et 12 clics, l’abus gagne.

4) IA Act : beaucoup d’ambition, mais une temporalité qui laisse un “trou”

L’AI Act et les outils associés (comme le Code of Practice pour les modèles généralistes) poussent vers plus de sécurité, transparence et documentation.

Sauf que, dans le réel, une partie de l’effectivité dépend du calendrier : certaines analyses rappellent que l’entrée en vigueur et l’enforcement s’étalent, laissant une période où la conformité repose fortement sur du volontaire, des garde-fous internes et la pression publique.

5) Le point le plus dérangeant : l’échelle, pas la qualification

Juridiquement, on peut qualifier, poursuivre, sanctionner. Mais cet événement dit surtout que le risque principal n’est plus “un montage isolé”, c’est la production à la chaîne : des dizaines, des centaines d’images générées, copiées, repostées, parfois sur des victimes différentes, et parfois sur des mineurs, ce qui fait exploser la gravité.

Conclusion critique : le droit avance (enfin) sur le deepfake sexuel. Mais tant que des plateformes permettront la génération sexualisée dans l’espace public, avec des garde-fous faibles et des signalements pénibles, la norme pénale restera un filet… posé après la chute. Le vrai levier, ce sont des choix de design : blocage des demandes “undress”, limites strictes sur l’édition d’images de personnes réelles, détection/traçage, et une modération réellement efficace, pas une vitrine.

FAQ – Grok retire sa robe

Qu’est-ce que “Grok retire sa robe” veut dire ?

“Grok retire sa robe” désigne l’usage de Grok (sur X) pour modifier des photos de femmes et les rendre plus sexualisées (bikini, lingerie, poses), souvent via une simple commande en réponse au post. Le problème central, ce n’est pas l’IA en soi : c’est le contenu sexuel attribué à une personne réelle sans son accord, puis diffusé publiquement.

Est-ce que Grok “déshabille” vraiment les femmes ?

Dans de nombreux cas rapportés, Grok ne génère pas une nudité totale, mais produit des versions semi-dénudées (bikini/lingerie) ou des modifications sexualisées. Juridiquement et socialement, l’impact peut être similaire : sexualisation imposée, humiliation, harcèlement. Le débat “nu ou pas nu” ne doit pas masquer l’essentiel : l’absence de consentement.

Est-ce illégal si l’image est “manifestement fausse” ?

Oui, ça peut l’être. Le droit ne sanctionne pas uniquement la “tromperie”. Il peut sanctionner la diffusion d’un contenu portant atteinte à l’image d’une personne sans son consentement, et il existe un traitement spécifique quand le contenu est à caractère sexuel. Même si tout le monde comprend que c’est généré, l’atteinte peut rester constituée.

Deepfake sexuel : quelles sanctions en France ?

En France, la diffusion de deepfakes non consentis a été explicitement visée par la loi, et les contenus sexuels font l’objet d’un régime plus sévère. Les peines peuvent aller jusqu’à de la prison et des amendes importantes, avec aggravation quand la diffusion se fait via un service de communication au public en ligne. La qualification exacte dépendra du scénario (diffusion, répétition, menaces).

Quelle différence entre “deepfake” et “montage” ?

Un montage est historiquement une manipulation (photo/vidéo) qui assemble ou altère un contenu. Un deepfake est un contenu généré ou transformé par des procédés algorithmiques (souvent IA) qui imitent un visage, une voix ou une apparence. En pratique, la frontière s’est réduite : ce qui compte, c’est la diffusion sans consentement, surtout quand cela touche à l’intime.

Que faire si quelqu’un a utilisé mon image avec Grok ?

Agis vite : captures d’écran (compte, post, réponse, date, URL), puis signalement sur la plateforme pour contenu intime/harcèlement, puis demande de retrait formalisée. Si le contenu circule ailleurs ou s’accompagne de pression, envisage une plainte. L’objectif est double : stopper la diffusion et conserver la preuve avant suppression.

Est-ce que je dois répondre publiquement à l’auteur ?

En général, non. Répondre peut nourrir l’attention, encourager le harcèlement ou déclencher d’autres copies. Priorise plutôt la preuve, le signalement, et le retrait. Si tu réponds, fais-le de manière factuelle (“contenu non consenti, signalé”) sans entrer dans un échange émotionnel. Tu protèges mieux tes intérêts avec une stratégie calme et documentée.

La plateforme peut-elle être responsable ?

La responsabilité de la plateforme dépend du cadre applicable et surtout de sa réactivité et de ses mécanismes de retrait. Quand un contenu illicite est signalé et que la plateforme n’agit pas, elle peut être exposée à des risques juridiques et réputationnels. Et quand l’outil génératif est intégré à la plateforme, la question des garde-fous devient encore plus sensible.

“C’est l’IA qui l’a généré” : est-ce une excuse ?

Non. Celui qui déclenche la commande, republie, tague ou diffuse reste responsable de ses actes. L’IA est un outil. Dire “ce n’est pas moi” revient à dire “ce n’est pas moi, c’est mon logiciel”. Juridiquement et moralement, ça ne tient pas : tu es responsable de l’usage que tu fais d’un outil quand il porte atteinte aux droits d’une personne.

Est-ce du revenge porn ?

Le revenge porn vise classiquement la diffusion d’images sexuelles “réelles” obtenues ou partagées sans consentement. Les deepfakes sexuels sont une extension moderne : tu peux subir une atteinte équivalente sans qu’aucune image intime n’ait existé. En France, le droit a évolué pour viser plus explicitement ces contenus. Dans les faits, l’expérience vécue par la victime peut être très proche.

Est-ce que je peux demander le déréférencement sur Google ?

Oui, si le contenu se retrouve indexé ailleurs (sites, forums, copies). Mais la priorité reste de faire retirer à la source (plateforme où le contenu est publié) et d’agir vite. Ensuite, tu peux demander un déréférencement lorsque c’est pertinent, surtout si cela touche à ton identité. Plus tu as de preuves et de décisions de retrait, plus ta demande est solide.

Comment éviter que ça arrive ?

Tu ne peux pas tout contrôler, mais tu peux réduire le risque : limiter certaines photos très identifiantes, régler ta confidentialité, surveiller les réponses “suspectes”, et agir au premier signal (montage, commentaire déplacé). Le meilleur bouclier reste la réactivité : plus un abus reste en ligne, plus il se copie. Se protéger, c’est souvent agir vite, pas “se censurer”.